Avec les LLM il n'y a vraiment pas de saison. Chaque jour - ou presque - des dernières versions et améliorations de grands modèles de langage sont annoncés. Cette fois c'est au tour de Google de s'y coller en complétant sa famille Gemma. Comprenant jusqu'alors des versions à 9 mais aussi 27 milliards de paramètres, le fournisseur vient de lancer une plus petite à "seulement" 2,6 milliards de paramètres. Celle-ci est une évolution de Gemma 2B sur laquelle la firme de Mountain View a travaillé pour répondre aux enjeux de développement IA plus verticaux. "Ce modèle léger produit des résultats surdimensionnés en tirant des enseignements de modèles plus importants par le biais de la distillation. En fait, Gemma 2 2B surpasse tous les modèles GPT-3.5 sur le chatbot Arena, démontrant ainsi ses capacités exceptionnelles en matière d'IA conversationnelle", annonce fièrement Google. Téléchargeable aussi bien sur Kaggle, Hugging Face que Vertex AI Model Garden, Gemma 2 2B est proposé sous licence ouverte spécifique permettant un usage commercial ou non. Contrairement aux licences "full" open source, celle-ci est assortie de conditions d'utilisation et de restrictions comme par exemple ne pas autoriser d'usage à des fins malveillantes.

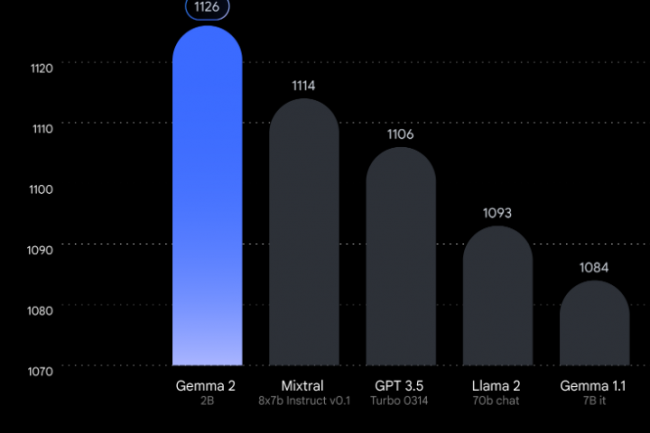

Selon un benchmark LMSYS repris par Google, Gemma 2 2B a obtenu un score de 1 126 sur le critère chatbot, dépassant Mixtral-8x7B (1 114) et GPT-3.5-Turbo-0314 (1 106). Ce LLM léger a été conçu pour générer et analyser du texte. Il peut fonctionner sur des terminaux en local tels que des ordinateurs portables ou des smartphones aussi bien que sur des environnements cloud tel que Vertex AI et Google Kubernetes Engine (GKE). "Pour améliorer encore sa vitesse, il est optimisé avec la bibliothèque Nvidia TensorRT-LLM et est disponible en tant que Nvidia NIM", indique Google. Pour rappel les NIM sont des microservices servant à optimiser les performance d'inférence.

Des classificateurs de sécurité pour prévenir des contenus déviants

Aux côtés de Gemma 2 2B, Google a également annoncé ShieldGemma, une suite de modèles de classification de sécurité conçus pour détecter et atténuer les contenus nuisibles dans les entrées et sorties des modèles d'IA. Le fournisseur explique que ShieldGemma cible spécifiquement quatre types de préjudice : discours de haine, harcèlement, contenu sexuellement explicite, ainsi que le contenu dangereux. Ces nouveaux classificateurs vont rejoindre la boite à outils d'IA éthique de Google (responsible AI toolkit) comprenant une méthodologie pour concevoir des classificateurs adaptés à une politique spécifique avec un nombre limité de datapoints ainsi que des classificateurs prêts à l'emploi sous forme d'API.

La firme de Mountain View a également levé le voile sur Gemma Scope pour apporter aux chercheurs et aux développeurs une capacité à rendre le fonctionnement interne de Gemma 2 2B plus interprétable. "Les auto-encodeurs épars (sparse autoencoders) sont des réseaux neuronaux spécialisés qui nous aident à décortiquer les informations denses et complexes traitées par Gemma 2, en les développant sous une forme plus facile à analyser et à comprendre", explique Google. "En étudiant ces vues élargies, les chercheurs peuvent obtenir des informations précieuses sur la manière dont Gemma 2 identifie les modèles, traite les informations et, en fin de compte, fait des prédictions."