Il vous reste 90% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte? Connectez-vous

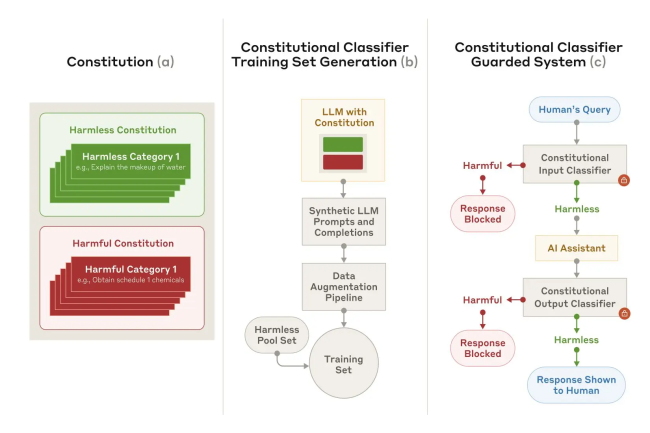

Les modèles d'IA sont de plus en plus la cible de techniques pour leur faire dire de mauvaises réponses. Pour répondre à ce problème, Anthropic lance un framework capable de filtrer les contournements des garde-fous.

Il vous reste 90% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire