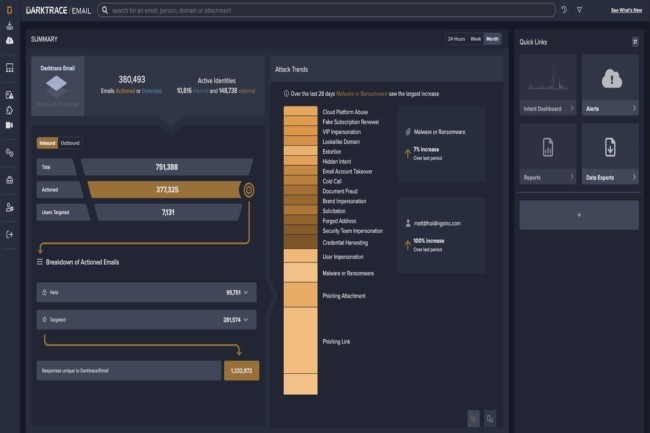

Les éditeurs de cybersécurité sont en train de se mettre en ordre de bataille face à la déferlante des IA génératives. Ces dernières conçues dans un cadre pacifique peuvent aussi aider les cybercriminels à améliorer leurs attaques. Face à cette tendance, Darktrace vient de mettre à jour son produit Email avec des fonctionnalités comme une boucle de rétroaction, une protection contre la prise de contrôle des comptes, des informations issues des endpoints, du réseau et du cloud, ainsi que des détections comportementales de courriels mal adressés

Un apprentissage du comportement normal des entreprises

« La fonction Cyber AI Loop peut détecter les attaques dès leur lancement », a indiqué l'entreprise dans un communiqué. En effet, selon Darktrace, l’outil n'est pas formé sur la base d'attaques passées et de comportements « malveillants » historiques, mais il apprend les modèles de comportements normaux de chaque entreprise. Cette fonction est essentielle pour lutter contre les récentes attaques par courrier électronique et les communications malveillantes complexes sur le plan linguistique, qui sont le fait de technologies d'IA comme ChatGPT et LLM.

Toujours selon l’éditeur, sa solution est capable de détecter ces attaques sophistiquées par courriel 13 jours plus tôt (en moyenne) que d’autres outils entraînés sur la connaissance des menaces passées. « Dans cette mise à jour, Cyber AI Analyst combine l'activité anormale des courriels avec d'autres sources de données, notamment les terminaux, le réseau, le cloud, les applications et l'OT, afin d'automatiser les enquêtes et les rapports d'incidents », a déclaré la firme. Selon elle, « grâce à cette contextualisation plus large autour de ses découvertes, l'IA de Darktrace peut désormais prendre des décisions plus éclairées, les algorithmes fournissant une image détaillée de la « normalité » basée sur de multiples perspectives pour produire des conclusions fiables, contextualisées et exploitables ».

Parmi les autres fonctionnalités de Darktrace/Email, il y a la protection combinée contre la prise de contrôle de comptes et celle du courrier électronique dans un seul produit. De même, la détection comportementale des courriels mal adressés, afin d'empêcher l'envoi de propriété intellectuelle ou d'informations confidentielles au mauvais destinataire. Par ailleurs, il comprend une gestion plus fine pour mieux lutter contre les graymail, le spam et les lettres d’information qui encombrent les boîtes de réception. L’outil comprend aussi des enquêtes automatisées sur les incidents liés aux mails.

Les attaques par emails générés par ChatGPT progressent

Depuis le lancement de ChatGPT par OpenAI l'année dernière, la capacité du chatbot à rendre les attaques d'ingénierie sociale/phishing plus sophistiquées, plus faciles à réaliser et ayant plus de chance de réussir a suscité de nombreux débats et inquiétudes. Selon les données de Darktrace, de janvier à février 2023, les attaques d'ingénierie sociale contre des milliers de ses clients actifs ont augmenté de 135 %, en phase avec l'adoption massive de ChatGPT. « Ces attaques impliquent l'utilisation de techniques linguistiques sophistiquées, notamment l'augmentation du volume du texte, de la ponctuation et de la longueur des phrases », a indiqué le fournisseur. En outre, 82 % des 6 711 employés internationaux interrogés par Darktrace craignent que les attaquants exploitent l'IA générative pour créer des courriels frauduleux impossibles à distinguer d'une communication authentique.

La semaine dernière, Europol a alerté sur la capacité de ChatGPT à rédiger des textes très réalistes, le rendant très utile pour le phishing. De plus, l'habileté des LLM à reproduire des modes d’expression peut servir à imiter le style de discours d'individus ou de groupes spécifiques. « Cette capacité est exploitable à grande échelle pour tromper les victimes potentielles et les inciter à faire confiance à des acteurs criminels », a encore déclaré Europol. En février, une étude menée par BlackBerry auprès de 500 décideurs informatiques britanniques a révélé que 72 % d'entre eux étaient préoccupés par l’usage potentielle de ChatGPT à des fins malveillantes. La plupart d’entre eux pensent que des États étrangers utilisent déjà l’assistant conversationnel contre d'autres nations. Par ailleurs, 48 % des personnes interrogées croient qu’au cours des 12 prochains mois, ChatGPT sera impliqué dans une cyberattaque réussie, et 88 % estiment qu’il revient aux gouvernements de réglementer les technologies avancées comme ChatGPT.

Commentaire