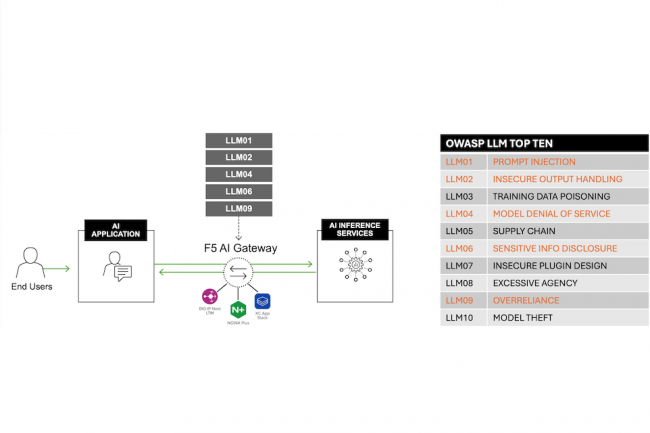

Pour aider les entreprises à mieux gérer la production et la sécurité des traitements IA, F5 met en avant sa passerelle AI Gateway, une solution automatisée pour sécuriser et gérer les interactions entre les applications d'IA, les API et les grands modèles de langage (LLM). Selon le fournisseur, ce service Kubernetes conteneurisé peut être déployé seul ou intégré aux logiciels, matériels ou services F5 existants. La passerelle prend en charge les modèles d'IA populaires comme OpenAI, Anthropic, Ollama ainsi que les LLM génériques HTTP en amont et les services de petits modèles de langage (Small Language Model, SLM). Selon Lori MacVittie, ingénieure distinguée de l’équipe CTO de F5, les applications d'IA présentent des défis uniques en matière de sécurité, de surveillance et de livraison. « La nature non déterministe des applications d'IA représente un défi important, du fait que les données entrantes et les réponses sortantes varient considérablement et évoluent au fil du temps. De plus, les applications d'IA peuvent tirer des données de sources structurées et non structurées qui résident sur plusieurs sites », a écrit Mme MacVittie dans un blog à propos de la passerelle.

« Le problème avec les entrées et les sorties non structurées et imprévisibles, c’est la difficulté inhérente à déterminer si une demande ou une réponse contient des informations sensibles ou incorrectes. Même si la sécurité des API et les pare-feux des applications web sont souvent utilisés à cette fin, ils fonctionnent sur la base d'un contenu déterministe. En d'autres termes, le format et le contenu des demandes et des réponses sont compris et il est donc plus facile de détecter un contenu malveillant ou sensible. L'IA exploite les mêmes constructions que les API et les applications web, mais le contenu est très variable, si bien qu’il est difficile d’élaborer des politiques capables d’analyser ou de nettoyer les demandes et les réponses », a expliqué Mme MacVittie.

Mieux accompagner les plateformes IA

La passerelle F5 AI Gateway offre un certain nombre de fonctionnalités pour gérer les environnements d'IA, notamment la possibilité de décharger les tâches dupliquées des LLM grâce à la mise en cache sémantique, toujours selon Lorri MacVittie. « Elle permet aussi le routage du trafic et la limitation du débit pour les grands modèles de langage locaux et tiers (LLM) afin de maintenir la disponibilité et la performance du service et de contrôler les coûts », a déclaré F5. « Grâce à la mise en cache sémantique, il est possible d'accélérer les temps de réponse et de réduire les coûts opérationnels en évitant les tâches redondantes des LLM », a ajouté le fournisseur.

AI Gateway peut inspecter, identifier et bloquer les attaques entrantes comme l'injection d'invite, le traitement de sortie non sécurisé, le déni de service de modèle, la divulgation d'informations sensibles et le vol de modèle. « Pour les réponses sortantes, AI Gateway identifie et nettoie les informations personnelles identifiables PII et empêche les hallucinations. Les kits de développement logiciel (SDK) rendent possible l’application de règles opérationnelles et d’exigences de conformité pour les invites et les réponses afin de s'aligner davantage sur les besoins opérationnels », a précisé F5. « Des capacités supplémentaires comme le reporting de diverses métriques via OpenTelemetry, une attention particulière aux exigences des journaux d'audit, la mise en cache sémantique, la limitation du débit et le routage de modèle basé sur le contenu garantissent la prise en charge des trois exigences de sécurité et de livraison de l'IA : observer, protéger et accélérer », a aussi fait valoir Mme MacVittie. La passerelle AI Gateway peut être intégrée à la suite de sécurité des applications NGINX de F5 et aux plates-formes de livraison d'applications BIG-IP, ce qui permet aux clients de bénéficier d'une intégration et d'un accès traditionnels.

Commentaire