En direct de Las Vegas. La première journée de l’évènement Dell World a fait la part belle à la brique infrastructure de l’AI Factory. La seconde s’est focalisée sur une autre brique, un écosystème ouvert. Michael Dell expliquait lors d’une conférence de presse que « le monde des LLM ne cesse d’évoluer vers des modèles plus petits, plus personnalisés, certains sont propriétaires et s’orientent maintenant vers l’open source, d’autres le sont dès le début ». Et de rappeler, « un LLM n’a aucune valeur, s’il n’est pas confronté au monde réel (NDLR : à savoir les données de l’entreprise) ». Reste que les sociétés sont confrontées à des interrogations sur le bon choix en matière de modèle.

Llama 3 de Meta et Hugging Face pour des LLM on premise

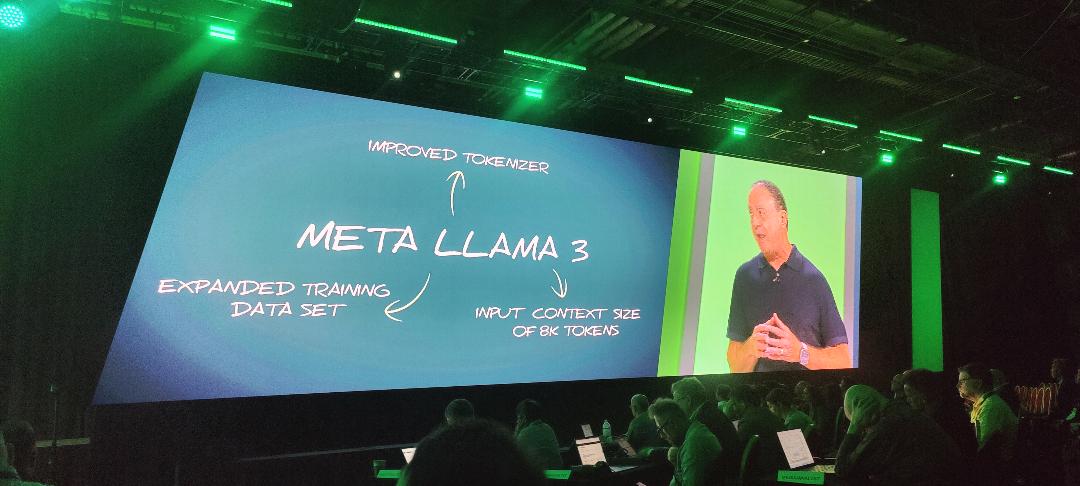

Dans ce cadre, Dell Technologies veut les aider à travers des partenariats avec une intégration plus poussée. C’est le cas avec Meta et son dernier modèle Llama 3. Les deux sociétés ont déjà travaillé ensemble pour porter Llama 2 en mode on premise pour les clients de Dell. Pour Jeff Clarke, COO de Dell Technologies, « l’objectif est d’apporter l’IA à vos data » et de rappeler que « 83% des données des entreprises sont sur site ». Sur scène, Sy Choudhury directeur des partenariats IA de Meta a vanté les mérites de son modèle, « une grande précision et un meilleur raisonnement » et travaille sur plusieurs axes avec Dell « l’entraînement, l'optimisation, le fine tuning et la sécurité ». De son côté, le constructeur Texan fournit des guides de déploiement et des tests de performance.

Les travaux communs entre Meta et Dell pour porter Llama 3 sur site via IA Factory. (Crédit Photo: JC)

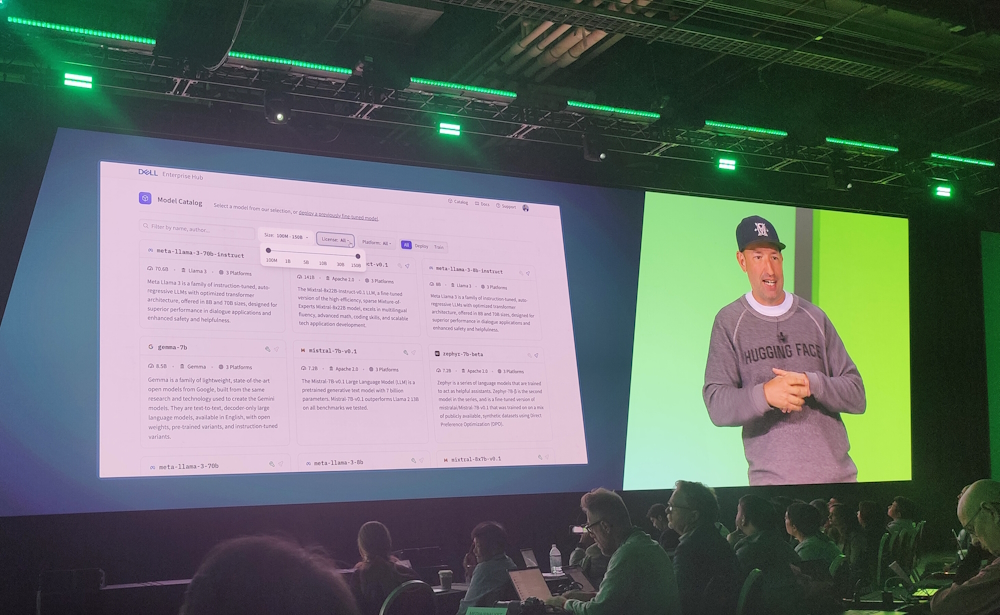

L’autre partenariat est avec Hugging Face, la start-up franco-américaine qui développe des outils pour créer des applications utilisant le machine learning et des modèles d'intelligence artificielle (IA) open source. Là encore, les deux sociétés travaillent ensemble depuis fin 2023 sur la création d’un portail « Hugging Face Dell » comprenant des conteneurs et des scripts dédiés à l'inférence et à la mise au point de modèles d'IA générative, Ce portail a maintenant un nom « Dell Enterprise Hub » qui selon Jeff Boudier, chef produit chez Hugging permet « de réaliser l’entraînement, l’inférence et le fine tuning sans changement de code ». A noter que ces deux accords ne sont pas exclusifs, précise Matt Baker, senior vice-président en charge de la stratégie IA chez Dell, « nous travaillons aussi avec Mistral, Falcon et avec Microsoft sur des modèles non captifs ». D’autres annonces de partenariat sont donc attendre dans les prochains mois.

Jeff Boudier, chef produit chez Hugging Face a fait la démonstration du Dell Enterprise Hub. (Crédit Photo: JC)

Le projet Helix migre dans IA Factory

Dans le package des partenariats, il ne faut pas oublier Nvidia. En 2023, les deux firmes avaient collaboré sur le projet Helix pour proposer une plateforme logicielle et matérielle on premise que les entreprises pourront utiliser pour entraîner leur propre modèle avec leurs datas. Dans sa besace, Dell apportait les serveurs PowerEdge (notamment XE9680 et R760 xa) optimisés pour fournir des performances pour l'entraînement et l'inférence de l'IA générative. La contribution de Nvidia porte sur les GPU H100 Tensor Core et des composants réseaux, ainsi que la suite de logiciels dédiés à l’IA comprenant le LLM NeMo et NeMo Guardrails pour créer des chatbots sécurisés.

Quelques mois après « le paysage de l’IA a un peu changé », observe Jeff Bourdeau, chief AI officer chez Dell. Le projet Helix était une expérimentation « très axée sur l’entraînement des modèles » explique le dirigeant avant d’ajouter qu’aujourd’hui, « il y a des besoins d’inférence et de RAG (retrieval augmented generation) pour répondre aux besoins métiers ». Voilà pourquoi, le projet Helix a été absorbé au sein d’IA Factory. Les travaux communs ne sont pas perdus et mis à jour avec les dernières évolutions hardware et software. Sur la partie inférence en particulier, Nvidia met en avant NIM (Nvidia Inference Microservices) et sur le RAG, Dell propose la solution Accelerator Services for RAG sur les stations de travail Precision qui s’appuie sur la plateforme de développement Workbench de Nvidia.

Commentaire