Progressivement, la plateforme de développement d’application d’IA d’AWS s’étoffe. En effet, le fournisseur de cloud enrichit Bedrock avec plusieurs fonctionnalités. Parmi elles, il y a l’ancrage contextuel ou contextual grouding intégré à Guardrails (fonction de protection et de sécurité) « pour atténuer les risques de réponses injustifiées ou hallucinatoires de la part d'une application basée sur un LLM », indique Vasi Philomin, vice-président de l’IA générative chez Amazon. Il ajoute que cette fonction, « utilise les méthodes RAG et de résumé pour détecter les hallucinations dans les réponses du modèle, vérifie si la réponse LLM est basée sur les bonnes données de l'entreprise et qu’elle est bien alignée sur la requête ou l'instruction de l'utilisateur ».

Guardrails en mode autonome

D'autres grands fournisseurs de services cloud comme Google et Microsoft Azure, ont aussi mis en place un système pour évaluer la fiabilité des procédés RAG, comme la cartographie des métriques de génération de réponses. Alors que Microsoft utilise l'API Groundedness Detection pour vérifier si les réponses textuelles des LLM sont fondées sur les documents sources fournis par les utilisateurs, Google a récemment mis à jour les options d’ancrage de Vertex AI en le dotant notamment de fonctionnalités de récupération dynamique et d’un mode haute-fidélité. AWS propose aussi des fonctions d'évaluation et d'observabilité RAG dans Bedrock pouvant mesurer la fidélité, la pertinence de la réponse et la similarité sémantique de la réponse pour apprécier la qualité de la réponse à une requête.

AWS proposera Guardrails pour Amazon Bedrock en tant qu'API distincte utilisable avec les LLM hors de Bedrock. « Suite aux nombreuses demandes d'entreprises clientes qui souhaitent utiliser l'API Guardrails sur des modèles en dehors de Bedrock, celle-ci est disponible de manière autonome », a déclaré Vasi Philomin. La décision d'AWS rappelle la stratégie d'IBM qui, depuis mai dernier, a rendu son produit watsonx.governance accessible via une boîte à outils. Même si cette dernière n’est pas exactement comparable à l'API Guardrails, elle peut servir à créer un référentiel pour les détails de journalisation tout au long du cycle de vie d'un modèle. Ces informations peuvent s’avérer utiles pour évaluer la validité du choix d’un modèle ou pour déterminer quelle partie prenante a été impliquée dans le cycle de vie du modèle.

Plus de connecteurs RAG et de LLM

Les autres mises à jour du service d'IA générative concernent l’ajout de connecteurs RAG à Bedrock pour étendre les possibilités d’ancrage des modèles dans une plus grande variété de sources de données. « En plus d'Amazon S3, les développeurs peuvent désormais utiliser des connecteurs pour Salesforce, Confluence et SharePoint pour RAG », a constaté Vasi Philomin, en précisant que le connecteur SharePoint était actuellement en avant-première. AWS a également annoncé qu’il était à présent possible d'affiner Claude 3 Haiku d'Anthropic à l'intérieur de Bedrock. « À ce jour, cette option, aussi en avant-première, n'est disponible chez aucun autre fournisseur de services cloud et elle est très recherchée par les entreprises clientes », a fait valoir le dirigeant.

D'autres mises à jour incluent la disponibilité générale de la recherche vectorielle pour Amazon MemoryDB et des capacités supplémentaires pour Agents for Bedrock. « Dorénavant, les agents peuvent conserver la mémoire à travers de multiples interactions pour se souvenir de l'endroit où s’est arrêté l’utilisateur la dernière fois et fournir de meilleures recommandations basées sur les interactions précédentes », a expliqué Vasi Philomin, ajoutant que les agents pouvait désormais interpréter le code pour s'attaquer à des cas d’usage complexes axés sur les données, comme l'analyse et la visualisation de données, le traitement de texte, la résolution d'équations et les problèmes d'optimisation.

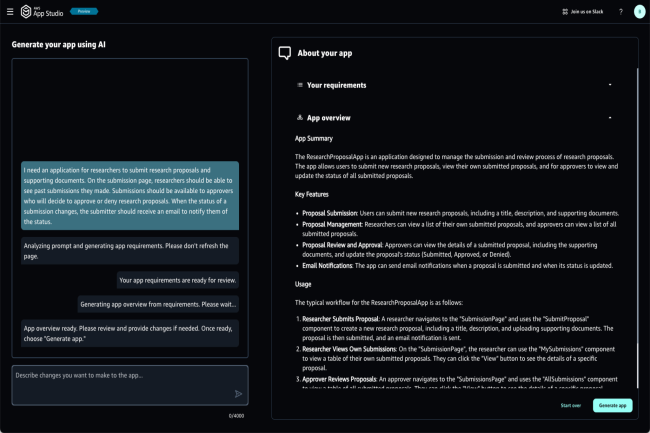

App Studio crée des applications de GenAI d'un simple prompt

AWS a aussi présenté le service managé App Studio basé sur l'IA générative qui propose aux utilisateurs de créer et de déployer des applications à l'aide d'invites en langage naturel. « Avec App Studio, un utilisateur décrit simplement l'application qu'il veut, ce qu'il veut qu'elle fasse, et les sources de données avec lesquelles il veut s'intégrer, et App Studio construit une application en quelques minutes, alors qu’il aurait fallu plusieurs jours à un développeur professionnel pour créer une application similaire à partir de zéro », a déclaré AWS dans un communiqué. « Avec l'assistant d’IA générative d'App Studio, il n’est plus nécessaire d'apprendre à utiliser les outils low-code », a encore affirmé l'entreprise. Amazon App Studio pourrait rivaliser avec des offres concurrentes comme Vertex AI Studio de Google et Copilot Studio de Microsoft.

AWS a aussi annoncé la disponibilité générale de Q Apps, une fonctionnalité de Q Business présentée lors de la conférence AWS re:Invent 2023. « Avec Q Apps, les entreprises peuvent passer en quelques secondes d'une conversation à une application générative alimentée par l'IA et basée sur les données de leur entreprise. Les utilisateurs décrivent simplement l'application qu'ils souhaitent dans une invite et Q la génère instantanément », a rappelé AWS. Le fournisseur a aussi indiqué que Q proposerait aux utilisateurs de générer une application à partir d'une conversation existante.

Commentaire