DataStax a annoncé un partenariat avec la start-up ThirdAI, basée à Houston, afin d'intégrer de grands modèles de langage (LLM) à ses offres de bases de données, notamment Enterprise pour les applications sur site et AstraDB, une base de données NoSQL en tant que service. Selon Ed Anuff, chef de produit chez DataStax, ce partenariat s'inscrit dans la stratégie de l'entreprise qui vise à apporter l'intelligence artificielle là où résident les données. ThirdAI peut être installé dans le même cluster, sur site ou dans le cloud, que DataStax, car il est livré avec une petite bibliothèque et l'installation peut être traitée avec Python. « L'avantage, c’est que les données ne doivent pas passer de DataStax à un autre environnement, elles sont simplement transmises à ThirdAI qui lui est adjacent. Cela garantit une confidentialité totale et une rapidité d'exécution parce qu'il n'y a pas de temps perdu dans le transfert des données sur un réseau », a déclaré un porte-parole de DataStax. « ThirdAI peut être exécutée en tant que paquet Python ou il est accessible via une API, selon les préférences du client », a ajouté le porte-parole.

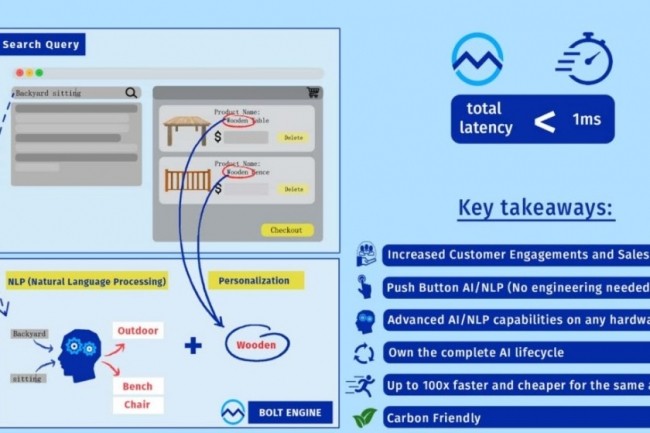

Les entreprises utilisatrices de DataStax Enterprise ou d’AstraDB peuvent exploiter les données résidant dans ces bases de données ainsi que la technologie et les LLM de ThirdAI pour créer leurs propres applications d'IA générative. Les modèles de base de ThirdAI peuvent être entraînés à comprendre les données et à répondre à des requêtes, par exemple, recommander un produit susceptible de déboucher sur une vente, sur la base de l'historique d'un client. Avec l'intégration des LLM de ThirdAI, DataStax pourra s'imprégner de la technologie Bolt de la start-up, qui permet d'obtenir de meilleures performances d'entraînement à l'IA sur les CPU par rapport aux GPU, pour des modèles relativement petits. L'avantage, c’est que le prix des CPU est généralement inférieur à celui des GPU, souvent utilisés pour les charges de travail d'IA et d'apprentissage machine.

Une intégration facilitée aux pipelines ML Python

« Le moteur Bolt, qui est un accélérateur algorithmique pour l’entraînement de modèles d'apprentissage profond, peut réduire les calculs de manière exponentielle. L'algorithme effectue l'entraînement des réseaux neuronaux en 1 % ou moins d'opérations en virgule flottante par seconde (FLOPS), bien mieux que des ruses courantes comme la quantification, le « pruning » ou élagage et le « structured sparsity » ou éparpillement structuré, qui n'offrent qu'une légère amélioration de facteur constant », explique ThirdAI. « Les accélérations sont naturellement observées sur n'importe quel processeur, qu’il provienne d'Intel, d'AMD ou d'ARM. Même les anciennes versions de CPU courants peuvent être capables d'entraîner des modèles à un milliard de paramètres plus rapidement que les GPU A100 avec le moteur Bolt », a ajouté l'entreprise. Selon ThirdAI, il est également possible d’invoquer Bolt en changeant « seulement quelques » lignes dans les pipelines d'apprentissage machine Python existants.

L'annonce de ThirdAI est la première d'un autre programme de partenariat mis en place par DataStax pour utiliser davantage de technologies de start-ups d'IA qui peuvent aider les entreprises dont les données résident dans les bases de données Datastax, à développer des applications d'IA générative.

Commentaire