Avec une quinzaine d'annonces produits lors de sa dernière conférence Dash 2024 fin juin à New York ( qui a réuni 3 000 participants), le spécialiste d'origine française en observabilité - mais aussi de la gestion de la performance applicative (APM), de la sécurité... - , Datadog a fait feu de tout bois. "Nous avons beaucoup étendu notre portefeuille mais toujours dans une logique d'expansion de notre philosophie de base autour de l'observabilité pour identifier les problèmes que peuvent rencontrer nos clients", nous a expliqué Yrieix Garnier, vice-président produits chez Datadog. Car en plus de son positionnement historique sur ce segment de marché (où il rivalise depuis des années avec d'autres cadors du secteur comme Cisco/Splunk, BMC, New Relic...), l'éditeur français a ajouté au fil du temps bien des cordes à son arc. "Nous nous sommes étendus à l'APM, gestion des logs et à la sécurité pour compléter notre data platform unique tout en conservant toute sa cohérence", poursuit Yrieix Garnier.

Cet empilement de solutions et de fonctions supplémentaires ne se fait pas au détriment des besoins clients historiques. Au contraire puisque d'après l'éditeur, la plupart de ses clients utilisent au moins deux de ses solutions et certains allant à en cumuler entre 8 voire 10. "Depuis plusieurs années nous avons rajouter de la valeur au niveau de nos produits avec une innovation qui se réparti sur tous nos domaines", fait savoir Yrieix Garnier, précisant au passage que Datadog consacre plus de 600 M$ par an dans sa recherche et développement.

LLM Observability en GA et Kubernetes Autoscaling en bêta

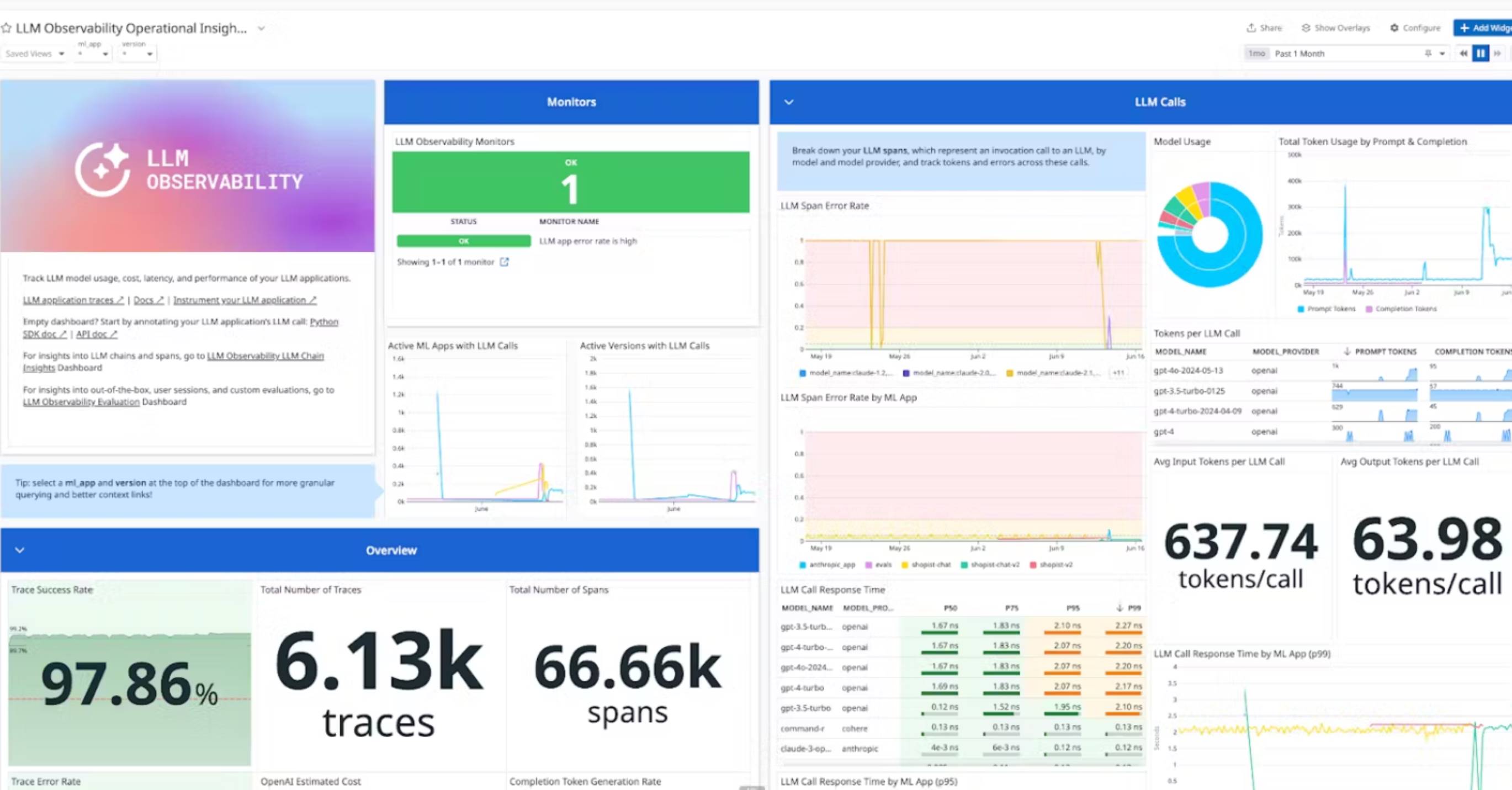

Dans la salve d'annonces faites lors de sa conférence Dash, quelques-unes sortent du lot. A commencer par sa solution d'observabilité dédiée aux LLM (LLM Observability) qui vient de sortie de la beta et arrive ainsi en disponibilité générale. "L'observabilité des applications développées avec des LLM et de la GenAI permet de suivre toutes les phases de leur développement jusqu'à leur mise en production pour faire remonter tous les problèmes", fait savoir Yrieix Garnier. Les types de problèmes détectés sont variés : problème de qualité d'un chatbot, hallucination, toxicité d'une réponse, défaut de sécurité... Cette observabilité repose sur des critères pertinents pour l'entreprise et personnalisables en fonction de ses attentes. "Cela permet par exemple dans le cas d'un magasin en ligne de détecter un problème de qualité d'une réponse d'un chatbot parce que le LLM sur lequel il repose n'a pas été entrainé sur tel ou tel catalogue", avance Yrieix Garnier. A noter que la solution d'observabilité LLM de Datadog est agnostique et fonctionne aussi bien avec OpenIA GPT, que Claude Anthropic ou encore Google Gemini.

Tableau de bord de LLM Observability. (crédit : Datadog)

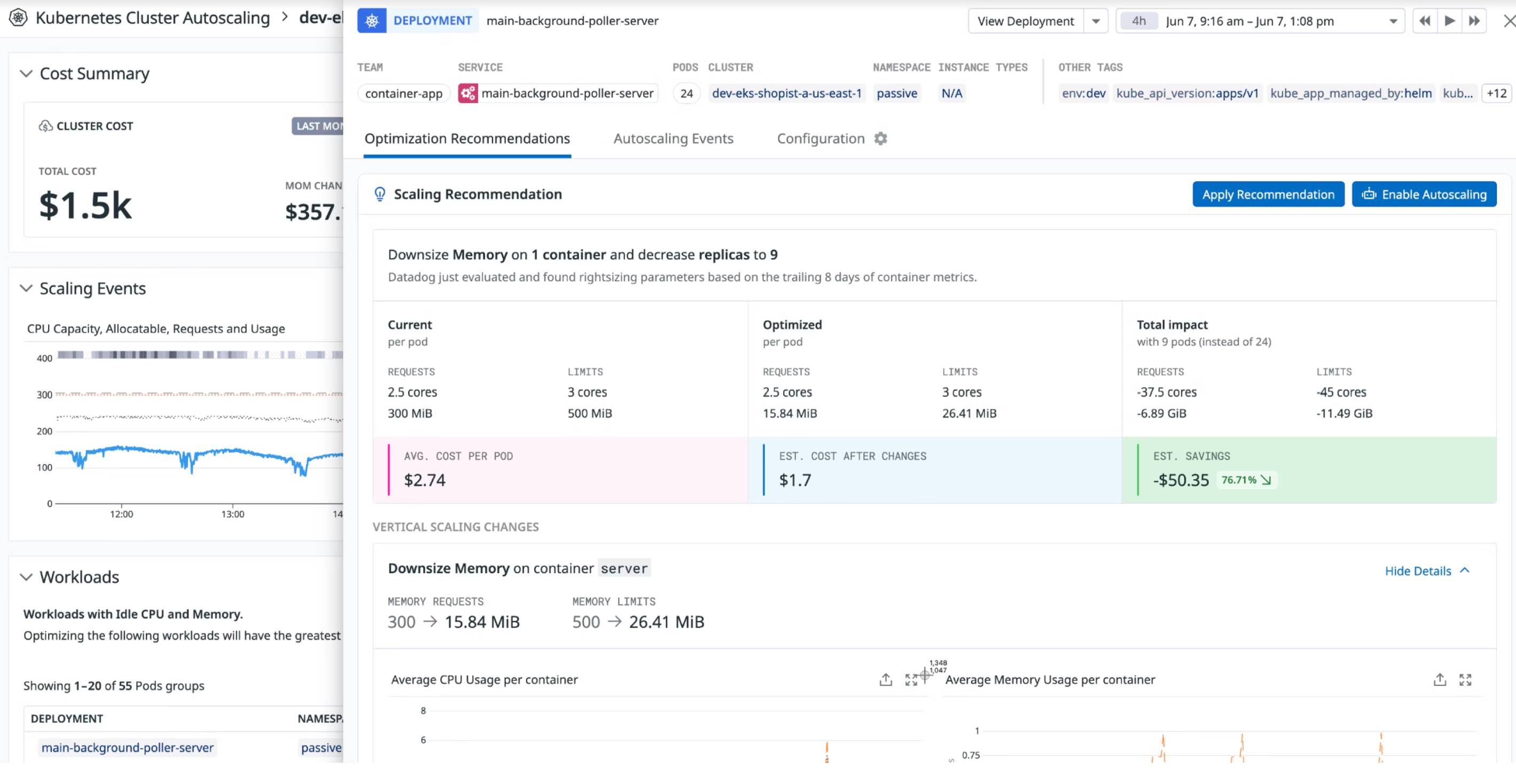

La fonction d'autoscaling de ressources Kubernetes (Kubernetes Autoscaling) arrive elle en beta. Son objectif ? Accroitre la visibilité sur les clusters de containers et déterminer automatiquement leur provisionning (CPU, mémoire...) en fonction de leur niveau d'utilisation. "Cela permet d'utiliser moins de ressources serveurs et d'allouer exactement le nombre et le type de ressources nécessaires pour faire tourner ses instances Kubernetes", indique Yrieix Garnier. Confiant sur la pertinence de son offre, Datadog utilise d'ailleurs ce produit à ses propres fins en interne. "Nous nous sommes aperçus que 65% des clusters clients utilisent moins de la moitié des ressources qui leur sont allouées et l'autoscaling permettrait de reduire le nombre d'instances inutiles, réduire l'empreinte serveur et dégager des économies d'électricité", explique le dirigeant. Datadog n'est pas le seul a avoir été séduit, c'est aussi le cas de plusieurs dizaines de clients de l'éditeur.

Tableau de bord de Kubernetes Autoscaling. (crédit : Datadog)

Commentaire