Le spécialiste du lakehouse a des ambitions dans l’IA générative. Il y a deux semaines, il présentait un LLM (grand modèle de langage) nommé Dolly. A la différence de GPT, ce modèle ne joue pas la course à la quantité de paramètres. Dolly fonctionne en prenant un modèle open source existant de 6 milliards de paramètres (contre 175 milliards pour GPT 3.5). Fun fact, le nom du modèle de Databricks fait référence au premier mouton cloné, car il s’agit d’un clone du modèle, Alpaca développé par des universitaires de Stanford, lui-même basé sur LLAMA de Meta. Les tests réalisés avec Dolly ont ainsi montré des résultats plutôt pertinents, constate Databricks, qui se vante par ailleurs d’avoir entraîné le modèle pour moins de 30 dollars.

Aujourd'hui, l’entreprise publie Dolly 2.0, un système à 12 milliards de paramètres basé sur la famille de modèles EleutherAI pythia et affiné exclusivement sur un nouvel ensemble de données de haute qualité de suivi d'instructions générées par l'homme, obtenu par crowdsourcing parmi les employés de Databricks. L’intégralité de ce modèle est mise en libre accès, y compris le code d'entraînement, l'ensemble de données et les poids du modèle, « tous adaptés à un usage commercial » précise le fournisseur dans un communiqué. En clair, toute organisation peut créer, posséder et personnaliser des LLM qui peuvent parler aux gens, sans avoir à payer pour l'accès à l'API ou à partager des données avec des tiers.

Un jeu de données signé Databricks

Pour la petite histoire, Dolly 1.0 a en effet été entraîné pour la modique somme de 30 $ à l'aide d'un ensemble de données que l'équipe Stanford Alpaca avait créé en utilisant l'API OpenAI. Cet ensemble de données contenait les résultats de ChatGPT et, comme l'a souligné l'équipe de chercheurs, les conditions d'utilisation visent à empêcher quiconque de créer un modèle concurrent d'OpenAI. Ainsi, pour contourner cette difficulté, Databricks a commencé à chercher des moyens de créer un autre ensemble de données. Se basant sur le document de recherche d'OpenAI, l’entreprise découvre que le modèle original InstructGPT a été formé sur un dataset comprenant 13 000 démonstrations de comportement de suivi d'instructions. Inspirés par cette expérience, Databricks a donc cherché à obtenir un résultat similaire avec ses employés.

Son jeu de données d’instruction open source, appelé databricks-dolly-15k, a été créé par plus de 5 000 employés du groupe au cours des mois de mars et avril 2023. « Ces enregistrements d'entraînement sont naturels, expressifs et conçus pour représenter un large éventail de comportements, du brainstorming et de la génération de contenu à l'extraction d'informations et à la synthèse » est-il précisé. Dans le détail, databricks-dolly-15k contient 15 000 paires d'invites/réponses de haute qualité générées par des humains et spécifiquement conçues pour l'ajustement des LLM. Selon les termes de la licence de databricks-dolly-15k (Creative Commons Attribution-ShareAlike 3.0 Unported License), tout le monde peut utiliser, modifier ou étendre ce jeu de données à n'importe quelle fin, y compris pour des applications commerciales.

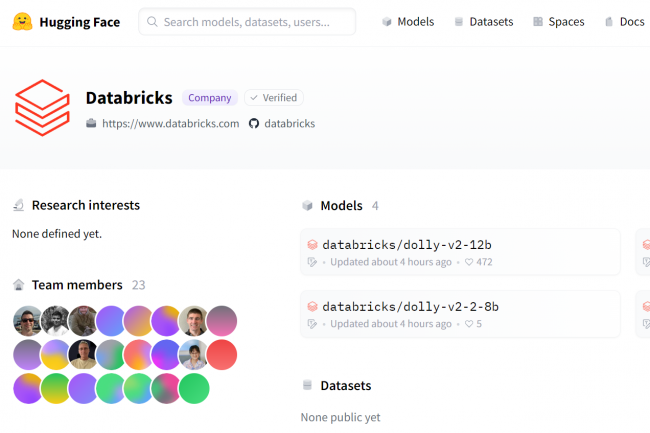

Une mise à disposition sur GitHub et Hugging Face

Pour télécharger le modèle Dolly 2.0, il suffit de se rendre sur la page Hugging Face (librairie de NLP open-source qui offre une API accédant à plusieurs modèles pré-entraînés) de Databricks et de visiter le répertoire Dolly sur databricks-labs pour télécharger le jeu de données databricks-dolly-15k. Ce dernier est également disponible sur GitHub.

Commentaire