Dans les discussions avec les DSI sur l’IA, le terme de confiance est récurrent. Néanmoins celle-ci ne se décrète pas et il faut pouvoir en apporter des preuves. C’est dans ce cadre que le programme de recherche Confiance.ai a vu le jour en 2019 en réunissant des chercheurs (laboratoires et universités) et des entreprises (Renault, Air Liquide, Airbus, Thales,…) pour travailler sur ce sujet. « Beaucoup de sociétés ont travaillé sur des PoC autour de l’IA, mais le passage à l’échelle sur des infrastructures critiques est plus compliquée », explique Juliette Mattioli, présidente du comité de pilotage du programme et experte en IA chez Thales à l'occasion d'un point presse au ministère de l'Economie et des finances.

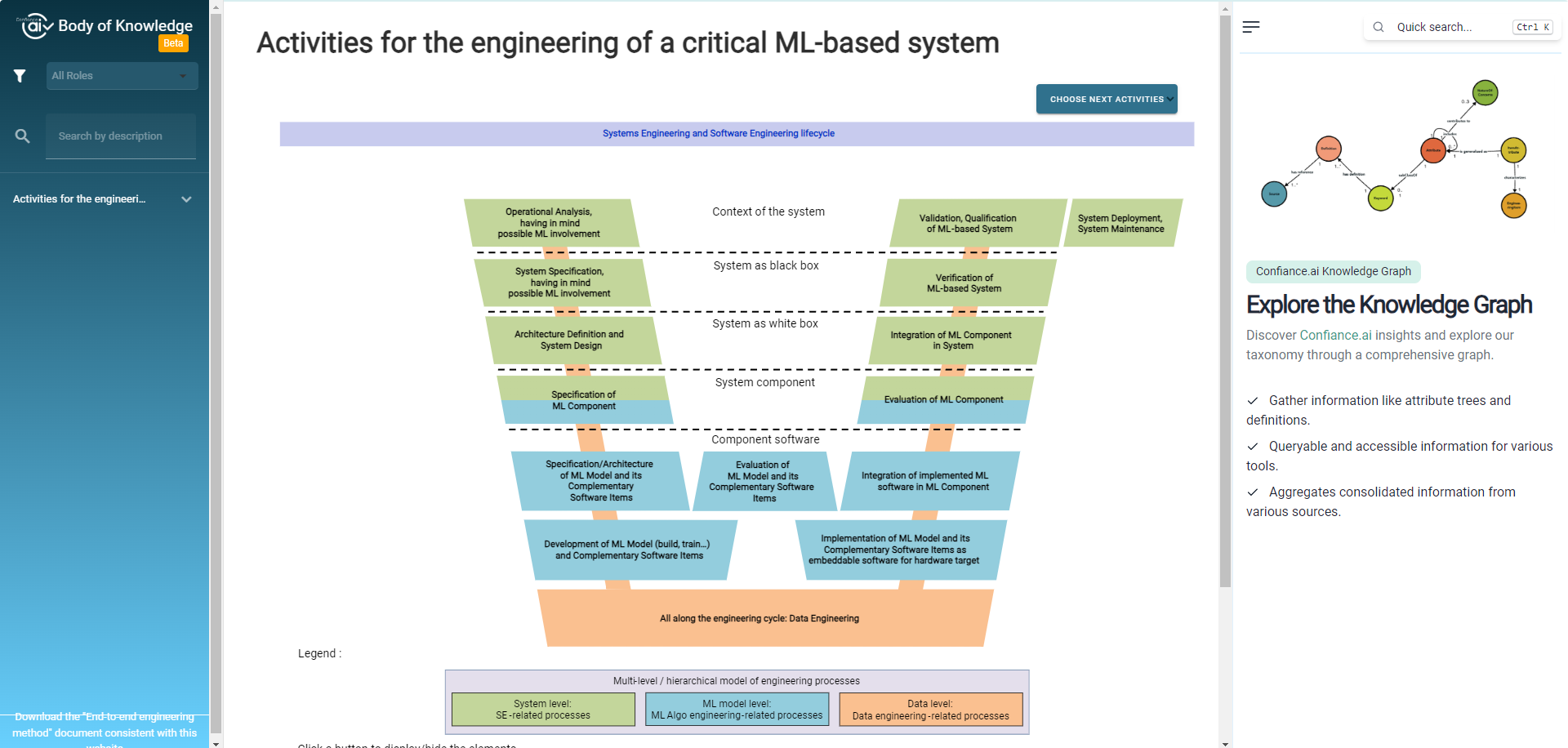

Il était donc important de travailler sur des référentiels et une méthodologie (disponible sur ce site) pour valider et certifier les composants IA prêts à intégrer ces systèmes industriels. Après trois années de travail, l’organisation a publié « une méthodologie de bout en bout allant de la spécification à la maintenance opérationnelle avec des attributs de confiance sur la qualification des données, la robustesse et le monitoring, l’explicabilité et la traçabilité, ainsi que la capacité à embarquer le composant », précise Juliette Mattioli. Elle ajoute que ces différents items ont été qualifiés par des usages réels. En parallèle de cette méthodologie, le programme publie une marketplace avec des outils open source et propriétaires qui ont servi à tester et à certifier les différentes briques. A noter par ailleurs, que les systèmes IA étudiés ne comprennent pas les LLM et l’IA générative. « Il y a beaucoup d’erreurs, de problèmes avec la fiabilité des sources et ils sont attaquables », explique Fabien Mangeant, directeur scientifique informatique et data science chez Air Liquide et président du comité de direction de Confiance.ai.

La méthodologie présentée comprend un site et un catalogue d'outils. (Crédit Photo : Confiance.ai)

Air Liquide optimise le comptage des bouteilles

Parmi les usages éprouvés, Air Liquide en a testé plusieurs. Un des exemples concerne le computer vision pour analyser via un portique dotée de caméras le chargement des bouteilles sur les camions entrant dans l’usine. L’objectif est de connaître le nombre exact de bouteilles pour connaître les stocks et planifier les opérations quotidiennes ou hebdomadaires d’embouteillage de gaz. Le problème était que « l’algorithme est sensible aux conditions météorologiques (pluie, neige) ou selon le jour et la nuit. Ces aléas peuvent entraîner des erreurs », se souvient Fabien Mangeant.

Le comptage du chargement de bouteille se fait via des caméras et du computer vision. (Crédit Photo : Air Liquide)

Le groupe industriel s’est donc appuyé sur les travaux du programme pour améliorer ce comptage dans des différentes conditions. Concrètement, il y a eu un pré-entraînement des données pour « purifier » certaines images, par exemple de prendre des photos de nuit et les adapter en plein jour, ou éliminer les gouttes de pluie ou les flocons de neige. Avec cette méthode, la précision de comptage est passée à 98% et le nombre d’erreurs a baissé de 50%.

Voiture autonome et l’aide à l’atterrissage

D’autres industriels ont également eu recours à la génération d’images synthétiques (des photos crées artificiellement pour que le modèle apprenne à détecter les erreurs et à mieux analyser les vraies images). C’est le cas dans l’automobile pour reconnaître des images comprenant de la neige. Le modèle de computer vision a été entraîné avec plus de 37 000 images réelles (sans neige) et plus de 5 500 images avec de la neige. La formation du modèle a duré 7 jours sur 2 GPU Nvidia Tesla V100. L’objectif de cette recherche est d’obtenir un bon niveau de précision dans une optique de conduite autonome. « Aujourd’hui, il reste encore des erreurs », souligne Amélie Bosca, data scientist chez Sopra Steria. Elle indique par exemple que sur des photos de nuit, des poteaux deviennent des feux de signalisation.

Une expérimentation porte sur la reconnaissance de la neige dans les véhicules. (Crédit Photo :DR)

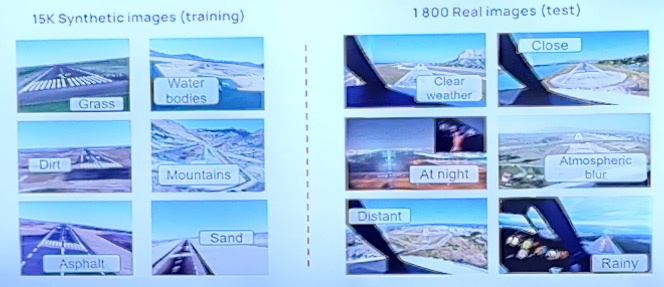

Cette approche est aussi testée dans l’aviation par Airbus avec le jeu de données LARD (landing approach runway detection) pour l’aide à l’atterrissage. En l’occurrence l’avionneur a généré environ 15 000 images synthétiques et 1 800 images réelles. Sur le premières, Airbus a travaillé avec Google Earth Studio pour générer des scénarios (piste avec des montagnes, de l’eau, du sable,…) en les rapprochant des images réelles. Dans cette expérimentation, la qualification des données, la robustesse des modèles d’IA, la capacité à les embarquer dans des environnements contraints (avions) ont été éprouvées et ont pu être intégrées dans la méthodologie de Confiance.ai.

Airbus a entraîné un modèle d'IA avec des images synthétiques et des images réelles. (Crédit Photo : Airbus)

A l'avenir, Confiance.ai va travailler sur l'IA générative malgré les réserves émises précédemment. Pour élaborer des attributs de confiance, le programme de recherche va étendre les cas d'usage. Il souhaite aussi développer une offre logicielle à destination de l'écosystème.

Commentaire