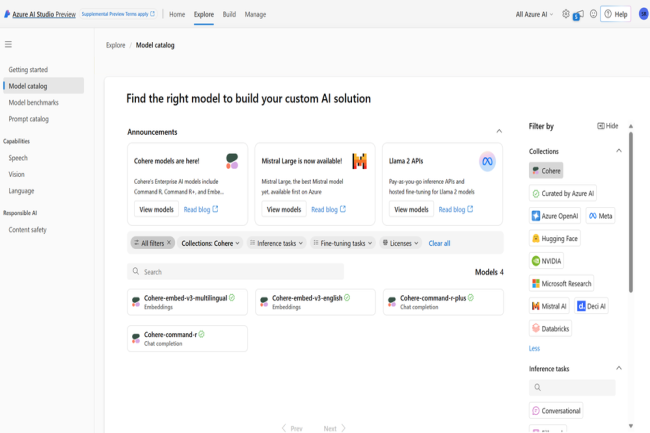

Une infidélité à OCI d’Oracle pour Cohere qui a décidé de porter son dernier LLM baptisé Command R+ sur Azure de Microsoft. Il s’appuie sur le modèle précédent en augmentant les performances de plusieurs tâches comme la catégorisation des données et l'automatisation des flux de travail. La porte n’est cependant pas fermée pour Oracle, car le LLM devrait arriver prochainement sur OCI et sur d’autres plateformes cloud. Il est déjà disponible via l’API hébergée de Cohere.

Du RAG et polyglotte

Les entreprises peuvent utiliser Command R+ pour intégrer leurs données et prendre en charge des applications personnalisées avec une précision accrue grâce au RAG (Retrieval-Augmented Generation), qui puise dans des bases de données externes pour obtenir des réponses plus précises et minimiser les erreurs. « Le RAG propose aux entreprises de laisser le modèle effectuer des recherches dans des bases de données privées et d'utiliser ces informations pour formuler des réponses plus précises et plus utiles », a expliqué le porte-parole de la start-up Kyle Lastovica. Il ajoute « les résultats du modèle sont accompagnés de citations claires et peuvent mettre en évidence un contexte supplémentaire à partir des documents sources qui limitent les hallucinations ».

Comme son prédécesseur, Command R+ dispose d'une fenêtre contextuelle de 128 000 tokens pour traiter les documents volumineux et fonctionne en dix langues, dont l'anglais, l'espagnol et le chinois. Dans un billet de blog sur le lancement de Command R+, le CEO Aidan Gomez a également mentionné les capacités d'automatisation des flux de travail du modèle, notamment de la possibilité d’appliquer le LLM aux workload des entreprises, depuis le CRM jusqu’à l'achèvement des commandes, en combinant plusieurs outils sur plusieurs étapes grâce à l'utilisation d'API et de LangChain, et en réessayant en cas de défaillance d'un outil.

Tarif premium

Par rapport au modèle précédent, les récentes fonctionnalités s'accompagnent d'un surcoût substantiel. Cohere facture l'accès à l'API de Command R+ six fois plus cher par jeton d'entrée et dix fois plus cher par jeton de sortie que Command R. Le dernier LLM coûte 3 dollars par million de jetons d'entrée et 15 dollars par million de jetons de sortie. Le modèle devrait profiter de l’essor du marché des logiciels d'IA pour les entreprises. Selon IDC, les investissements des entreprises dans les services, logiciels et infrastructures d'IA générative devraient passer de 16 milliards de dollars cette année à 143 milliards de dollars d'ici à 2027. Au cours de cette période de quatre ans, les dépenses en IA générative devraient augmenter à un taux de croissance annuel composé (TCAC) de 73,3 %. IDC note que ce taux est plus de deux fois supérieur au taux de croissance de l'ensemble des investissements dans l'IA et près de 13 fois supérieur au TCAC des dépenses IT mondiales au cours de la même période.

Commentaire