Les spécialistes du CDN (content delivery network) ont une carte à jouer dans l’IA. CloudFlare est un de ces acteurs et vient de présenter différents outils pour construire, déployer et exploiter les modèles d’IA. Le premier volet est le framework Workers AI qui s’appuie sur des accélérateurs IA à base de GPU (via des instances serverless) sur le réseau du fournisseur. Grâce à ce framework, les systèmes d'IA qui dépendent fortement de la latence pourront exécuter des charges de travail en mode edge soit au plus près des besoins. La firme ajoute que ce cadre est capable de séparer les données d’inférence et celles d’entraînement, garantissant ainsi que les informations ne seront pas utilisées à mauvais escient.

Vectorize pour vectoriser et Gateway pour surveiller

Deuxième volet de l’initiative de Cloudflare, la base de données vectorielle Vectorize. Avec elle, les développeurs peuvent créer entièrement des applications basées sur l’IA sur les systèmes du fournisseur de CDN. Elle fonctionne en tandem avec le réseau sous-jacent de Cloudflare, si bien que l’environnement d’exécution est là encore plus proche de l'utilisateur final. Enfin, comme Vectorize est intégré à Workers AI, les utilisateurs pourront générer des embeddings (prolongements lexicaux) dans Workers AI et les indexer dans Vectorize.

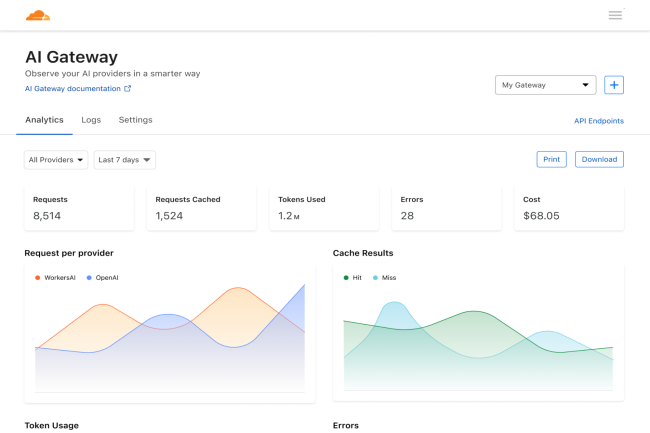

Dernier volet de l’initiative, le système de gestion et d'optimisation des performances AI Gateway qui apporte une observabilité sur les applications d'IA exécutées sur le réseau de Cloudflare. « AI Gateway fournit des données comme le nombre et la durée des requêtes, les coûts de fonctionnement de l'application et le nombre d'utilisateurs, ainsi que des options de réduction des coûts, par exemple en limitant les prompts et en conservant en cache des réponses aux requêtes courantes », comme l’explique la société.

Des partenariats

Le fournisseur a également annoncé des collaborations avec Microsoft, Databricks et la startup Hugging Face. La firme de Redmond apporte son runtime ONNX pour la continuité des modèles d'IA à travers le cloud, l’edge ou une utilisation sur un terminal, tandis que le partenariat avec Databricks donne accès à sa plateforme open source MLflow pour la gestion du cycle d'apprentissage automatique. Le réseau de Cloudflare sera le premier du genre à permettre aux clients de déployer les puissants modèles d'IA générative de Hugging Face dans un environnement serverless alimenté par des accélérateurs IA.

Matthew Prince, cofondateur et CEO de Cloudflare, a déclaré que ces offres représentaient une extension majeure de la plateforme de développement de l'entreprise, et que l'objectif était de rendre « l'infrastructure d'inférence » accessible à tous les clients potentiels. Selon le dirigeant, le réseau est le lieu idéal pour faire fonctionner l'IA. « Nous avons déjà constaté l'intérêt d'entreprises qui tentent de relever ce défi spécifique, à savoir offrir des expériences puissantes sans sacrifier la durée de vie de la batterie ou le temps de latence », a-t-il déclaré. « Cela dit, comme les LLM et l'IA font désormais partie de chaque application, nous pensons que Cloudflare est bien adapté pour les alimenter en facilitant le travail des développeurs ». Toutes les fonctionnalités annoncées sont disponibles immédiatement. La tarification sera essentiellement basée sur l’usage, avec des schémas différents pour Workers, Vectorize et AI Gateway. « Vectorize sera gratuit jusqu'en 2024 », a aussi précisé Matthew Prince.

Commentaire