Pour les traitements d’intelligence artificielle, les fabricants de puces rivalisent de créativité pour fournir le système le plus performant. Dans cette course, il faudra compter sur Cerebra Systems et sa dernière solution CS-1. A l’occasion de la conférence SC20 dédié au HPC, la société a mené une expérience en collaboration avec le laboratoire national des technologies énergétiques(NETL)du ministère américain de l’Energie.

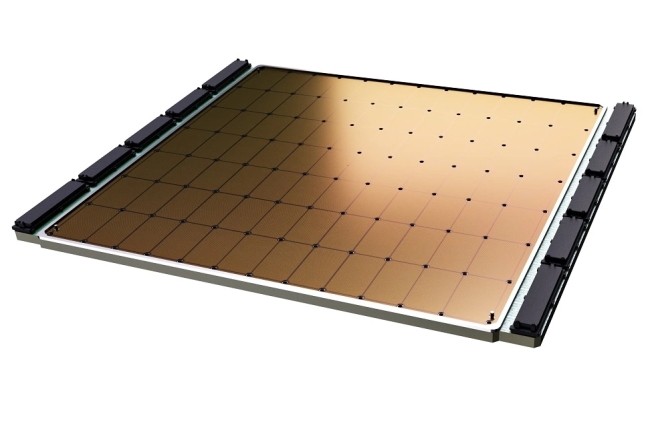

Pour mémoire Cerebras a été créé par Andrew Feldman, fondateur de SeaMicro. La société fabrique la plus grande puce au monde, la WSE. Traditionnellement, les fondeurs découpent des plaques de silicium de 12 pouces de diamètres et elles sont traitées en usine pour devenir des wafer. Une fois cela fait, le wafer peut comprendre des centaines de puces distinctes pouvant être utilisées dans du matériel. Dans le cas de Cerebras, le wafer est une seule et même puce. Chaque morceau de la puce, appelé cœur est interconnecté à haut débit à d’autres cœurs pour travailler ensemble. Le système CS-1 utilise donc un puce de la taille d’un wafer WSE comprenant 1,2 trillion (1200 milliards) de transistors. Pour comparaison, la GPU la plus performante annoncée hier par Nvidia, A100 80 Go, en compte 54 milliards.

200 fois plus rapide qu’un supercalculateur

Le système CS-1 a été confronté au supercalculateur Joule, 82ème dans le Top500. Il affiche 84 000 cœurs de CPU répartis sur des dizaines de racks, a coûté des dizaines de millions de dollars et consomme 450 kilowatts d'énergie. Dans la démonstration, le supercalculateur Joule a utilisé 16 384 cœurs, et le module équipé de la puce Cerebras était 200 fois plus rapide, selon le directeur du NETL Brian Anderson. Les charges de travail concernaient la modélisation de la dynamique des fluides.

Autre avantage, le module mesure 66 cm et tient dans un tiers de rack (comme le montre la photo ci-dessus). Il coûte plusieurs millions de dollars et consomme 20 kilowatts d'énergie. L’empreinte au sein de la salle est donc moindre. La recherche a été menée par Dirk Van Essendelft, ingénieur en apprentissage machine et en sciences des données au NETL, et Michael James, cofondateur de Cerebras et architecte en chef des technologies avancées. Les résultats ont été obtenus après des mois de travail.

Je lis : "Traditionnellement, les fondeurs découpent des plaques de silicium de 12 pouces de diamètres et elles sont traitées en usine pour devenir des wafer. Une fois cela fait, le wafer peut comprendre des centaines de puces distinctes pouvant être utilisées dans du matériel. "

Signaler un abusCe n'est pas tout à fait vrai : on exprime desormais le diamètre de ces plaques de silicium qu'on appelle aussi tranche et "wafer" en anglais en millimètre et ces tranches de 300mm de diamètre ne font pas 12 pouces mais 11,8 pouces. Ce sont les fournisseurs de tranche qui les fabriquent à partir d'un lingot de silicium monocristallin en découpant ce lingot et en polissant ces tranches. Ce qu'on appelle traditionnellement un fondeur est une grande entreprise (ex : TSMC, Samsung, Intel, GlobalFoundries etc) qui va par une succession de tres nombreuses etapes de procédés de lithographie , depots ou croissance de couches , gravure , implantation d'ions "graver" de nombreuses puces (generallement identiques) sur la puce qui peut ressembler à la fin à une gaufre (d'où le nom de wafer, gaufre en anglais).Ces puces sont séparées par sciage. Dans ce cas ici , au lieu de graver plusieurs centaines de puces de taille relativement petite (inferieure à 22 mm de coté , limitation liée à la taille des masques) , il s'agit d'une puce qui a une taille comparable et inferieure à la taille de la tranche de 300 mm de diamètre.