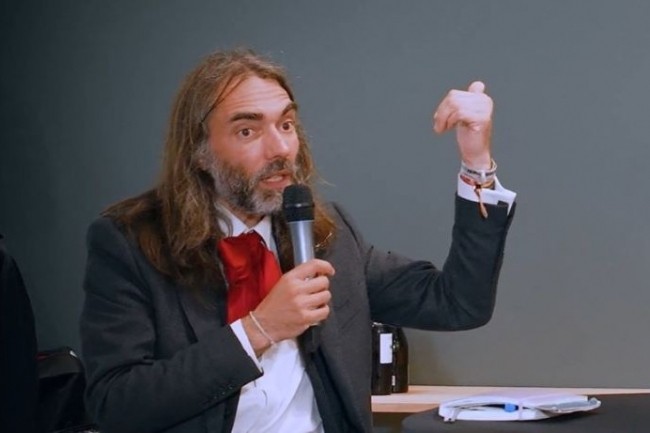

Invité de la rédaction de CIO, en marge de l'émission Grand Théma sur l'intelligence artificielle, le mathématicien Cédric Villani, médaille Fields en 2010, livre son analyse de la percée de l'IA générative. Et des risques qu'elle comporte. Tout d'abord en relativisant les discours marketing entourant l'émergence de cette technologie, qui est, selon l'ancien directeur de l'Institut Poincaré, « une rupture technologique, mais pas une rupture scientifique »,

Et de rappeler que les outils d'IA générative s'inscrivent dans une continuité, marquée, en 2012, par une percée des réseaux de neurones dans le déchiffrement de l'écriture manuscrite. Même si cette technique existait déjà, portée notamment par les travaux de Yann Le Cun. ChatGPT et l'actuelle vague de LLM ne sont, en définitive, que le prolongement de cette histoire, le fruit d'une dernière avancée issue des travaux des ingénieurs de Google. « Leur idée clef par rapport aux autres techniques de génération, c'est de ne plus se contenter de considérer simplement ce qui précède - le début de la phrase par exemple -, mais s'intéresser potentiellement à toutes les connexions d'un endroit du texte à un autre - le début du paragraphe d'avant, le premier mot de ce texte, etc. Ce n'est donc pas une révolution scientifique. Pourtant, ça marche ! », souligne Cédric Villani.

« Des objets éminemment politiques »

Ça marche ou, plus exactement, ça semble marcher. Car, dans l'IA générative, l'illusion de la véracité est plus importance que la véracité elle-même. Un texte en apparence érudit produit par un LLM peut renfermer des références farfelues, les fameuses hallucinations. « De la même façon qu'un stagiaire remplit un texte à trou par analogies à partir d'un corpus de références, sans comprendre le sens, ChatGPT et les autres ont été conçu pour dire le plausible, délivrer un résultat moyen qui sonne bien », résume le mathématicien.

Retrouvez la vidéo l'intervention de Cédric Villani (29 min)

Et ce dernier souligne également les risques de ces outils, des risques inhérents à leurs principes de fonctionnement, mais aussi liés aux corpus de données d'entrainement ou à leur concepteur. « Les LLM sont des objets éminemment politiques, car ils censurent telle ou telle nature d'informations », indique le mathématicien. Par exemple, quand Stella Assange, la femme du fondateur de Wikileaks Julian Assange, a interrogé les IA de Google et de Mistral AI sur les projets d'assassinat de son mari par les Etats-Unis, elle a obtenu des réponses très différentes : le premier écartant tout complot, tandis que le second fournit des éléments concrets appuyant l'existence d'un tel plan. En plus de maîtriser le corpus de données sur lequel est entraîné un modèle, une entreprise entendant limiter au maximum les risques de l'IA générative doit donc également s'appuyer sur un concepteur de modèle de confiance, souligne le mathématicien.

Environnement : attention à l'impact indirect

Pour ce dernier, les DSI pourront toutefois piocher parmi une offre très large. « Ce qui se dessine, c'est une floraison de grands modèles de langage, avec même des approches phylogénétiques comme dans l'évolution des espèces et des langages appliquées à des LLM. Il suffit de quelques dizaines de chercheurs motivés pour lancer son modèle. En fonction des approches de risques relatives à chaque usage, les entreprises auront donc des réponses et des offres différentes »

L'ancien député, engagé notamment dans Génération écologie (après avoir quitté LREM), s'inquiète également de l'impact environnemental de la technologie, y compris par effet indirect. Certes, l'IA a des impacts positifs. Comme au sein du GIEC, qui développe son propre modèle permettant de produire des rapports synthétisant de multiples études. Ou comme Mycophyto, une entreprise française qui sélectionne les meilleurs champignons mycorhiziens pour améliorer les sols grâce à la technologie. « Mais, l'IA va aussi servir à trouver le prochain méga-gisement de pétrole qui va bruler dans l'atmosphère, à vous persuader d'acheter le dernier SUV ou à semer le doute sur les conclusions du GIEC ou sur le besoin d'effectuer la transition vers les voitures électriques ou le vélo, souligne Cédric Villani. Or, tous ces usages sont du côté du modèle industriel dominant, donc sont associés à des moyens bien plus importants que ceux des acteurs du changement. Dans un contexte où la transition écologique est avant tout politique, cet effet secondaire de l'IA est, à mes yeux, bien plus important que l'impact direct en matière de consommation d'énergie ou de ressources. »

Retrouvez la vidéo l'intervention de Cédric Villani (29 min)

Cédric Villani : « L'IA générative n'est pas une rupture scientifique »

0

Réaction

Invité de la rédaction de notre confrère CIO, le mathématicien Cédric Villani replace la GenAI dans son contexte, contestant son statut de technologie de rupture. Et alerte sur les risques inhérents à ces outils et à leurs usages.

Newsletter LMI

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire