Comme l’année dernière, AWS a réuni les clients et partenaires à Paris au Palais des Congrès pour son traditionnel Summit. L’édition 2024 n’a pas échappé à la tendance du moment l’IA, mais le fournisseur rappelle que cette révolution ne peut pas se faire sans le cloud. Julien Groues, vice-président France et Europe du Sud d’AWS, reprend même l’analogie de l’iceberg où l’IA serait la partie visible et « le cloud comme partie invisible comme fondation, socle pour alimenter l’IA ». Un couple qui fonctionne notamment en France, « les entreprises françaises ont augmenté de 35% leur programme d’IA en 2023 », salue le dirigeant.

Berdrock disponible en France

Ce dernier n’est pas venu les mains vides sur la scène du Palais des Congrès en annonçant la disponibilité de Bedrock sur la région Europe de Paris. Ce service cloud lancé en avril 2023 propose aux développeurs de créer des applications basées sur des IA génératives à partir de modèles pré-entraînés fournis par des start-ups. A l’occasion de l’AWS Summit Paris, ce service s’enrichit du dernier modèle de Mistral nommé Large. Arthur Mensch, co-fondateur de la start-up française est venu sur scène pour expliquer qu’AWS « constitue un canal de distribution très efficace et dispose d’une infrastructure complète avec les instances Inferentia et Trainium ».

Tom Brown (à droite), co-fondateur d'Anthropic, était présent sur la scène du palais des Congrès aux côtés de Julien Groues, vice-président France et Europe du Sud d'AWS. (Crédit Photo : JC)

Mistral n’était pas le seul invité dans l’écosystème IA accueilli sur Bedrock. Thomas Wolf, co-fondateur de Hugging Face était aussi présent pour rappeler que « la première collaboration cloud était avec AWS ». La société propose un ensemble de modèles, de dataset et de démonstrateurs avec pour objectif de faciliter l’usage de l’IA et de citer quelques exemples autour du diagnostic du cancer ou de l’observation de la terre par un laboratoire de l’agence spatiale européenne. Même Tom Brown, co-fondateur d’Anthropic, avait fait le déplacement pour parler de l’importance de l’infrastructure AWS pour entraîner et développer ses récents modèles Claude. Une manière aussi de remercier la maison-mère du fournisseur qui a investi 4 Md $ dans la société.

Air Liquide mêle cloud et IA

Au cours du discours inaugural, Julien Groues a fait la part belle aux clients avec deux interventions sur l’usage du cloud et les expérimentations sur l’IA. Premier à intervenir, Fabien Mangeant, directeur scientifique informatique et data science chez Air Liquide qui rappelle que les liens entre AWS et la firme datent de 2014. Mais c’est en 2018 que la société lance un plan d’accélération de l’innovation avec un axe autour de la data et de l’IA. « Sur le plan technique, nous avons misé sur une approche infrastructure as a code en utilisant au maximum du serverless et de la conteneurisation afin de pouvoir passer à l’échelle », souligne le dirigeant.

Fabien Mangeant, directeur scientifique informatique et data science chez Air Liquide, est revenu sur les applications intégrant l'IA. (Crédit Photo : JC)

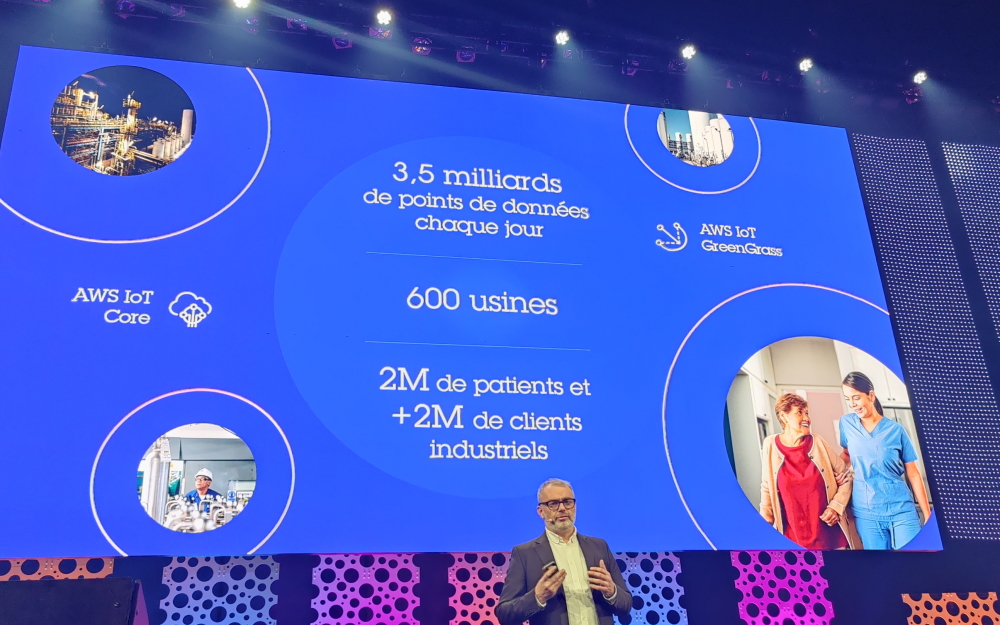

Il cite deux exemples d’applications développées sur cette plateforme, « la première concerne le domaine industriel pour optimiser la chaîne de la valeur de la production à la distribution en analysant 3,5 milliards de points de données chaque jour. Pour cela, nous nous servons de IoT Core et IoT Greengrass », précise Fabien Mangeant. La seconde application porte sur « l’approvisionnement des gaz médicaux avec comme objectif de personnaliser la distribution. Cela implique de mettre en place des éléments de confiance, car nous sommes dans ce cadre sur des données de santé », glisse le responsable. Un thème qu’il connait bien pour être le président du comité de direction du consortium Confiance.ai, qui vient récemment de présenter un référentiel pour une IA de confiance dans le monde industriel. Il se montre optimiste « sur les premiers tests et prototypes réalisés avec certains modèles via Bedrock » tout en étant très vigilant « sur les biais, l’opacité, les coûts, l’empreinte carbone de l’IA générative ».

TF1 accélère sur le streaming avec le cloud et l’IA

L’autre intervention client est TF1 à travers Raphaëlle Deflesselle, directrice de la technologie et des systèmes d’information. Elle rappelle qu’un média « c’est aussi un projet technologique avec une digitalisation de plus en plus forte des métiers et le déploiement du streaming ». Dans ce cadre, TF1 s’est servi de l’infrastructure AWS pour sa plateforme de streaming gratuit. L’occasion pour la dirigeante de donner quelques chiffres, « les rythmes de mises à jour sont passés d’un mode annuel à plusieurs mises à jour mensuellement. Sur le plan de la sécurité, 40 millions de requêtes illégitimes ont été contenues pendant la diffusion de la coupe du monde de foot en décembre 2022. Nous avons par ailleurs un système de secours de production des JT sur le cloud d’AWS avec 100% des fonctionnalités disponibles pour les journalistes ».

Raphaëlle Deflesselle, directrice de la technologie et des systèmes d’information de TF1 est venue témoigner de l'usage de l'IA et des apports d'AWS dans les plateformes de streaming. (Crédit Photo: JC)

En 2024, le groupe de média est monté en puissance dans le streaming gratuit en lançant TF1 + et affiche déjà 4 millions d’utilisateurs par jour. « Cette plateforme repose sur trois piliers : le cloud, la data et l’IA », explique Raphaëlle Deflesselle. Concernant, l’IA, elle a permis deux innovations, « la première est top chrono qui propose à l’utilisateur de faire son propre résumé d’un match et la seconde qui est en cours, Synchro est un service de recommandation de contenu pour un groupe d’ami ou la famille ». Dans la roadmap de la DSI, le recours à l’IA générative va être renforcé en se servant de l’offre Rekognition et Bedrock, « pour vérifier la conformité de nos contenus, la qualité, la présence de marques sur le tabac et l’alcool, la charte de TF1, la nudité, etc. », conclut-elle.

Commentaire