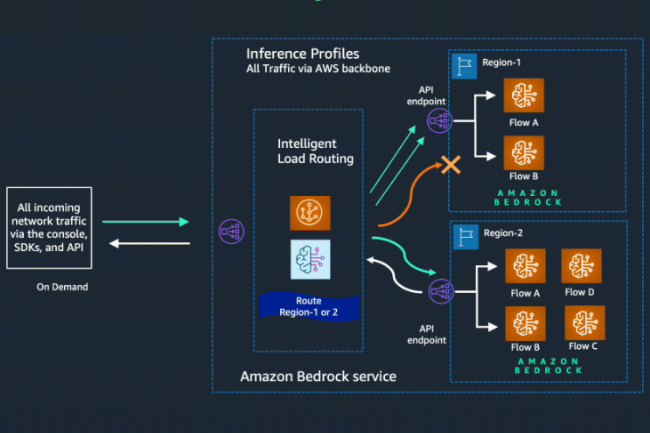

Désormais disponible pour tous, la fonction dite cross-region inferencing au sein du service d’IA générative Bedrock d’AWS achemine dynamiquement le trafic à travers plusieurs régions. Elle préserve ainsi la disponibilité optimale pour chaque demande provenant d'applications alimentées par Bedrock et d'améliorer les performances pendant les périodes de forte utilisation.

Un modèle à la demande ou par lots

Dans le mode à la demande, les développeurs payent pour ce qu'ils utilisent sans engagement à long terme, contrairement au mode par lots, pour lequel ils fournissent un ensemble d'invites sous forme de fichier d'entrée unique et reçoivent des réponses sous forme de fichier de sortie unique, ce qui leur permet d'obtenir des prédictions simultanées à grande échelle. « En optant pour ce mode, les développeurs n'ont plus à prévoir les fluctuations de la demande », a écrit l'entreprise dans un billet de blog. « De plus, cette fonctionnalité donne la priorité à la source/région primaire connectée de l'API Bedrock quand c’est possible, ce qui réduit la latence au minimum et accroît la réactivité. Par conséquent, les clients peuvent améliorer la fiabilité, les performances et l'efficacité de leurs applications », a ajouté le fournisseur.

Les développeurs peuvent commencer à utiliser l'inférence inter-régions via des API ou la console Bedrock AWS pour définir la région primaire et l'ensemble des régions secondaires où les demandes seront acheminées en cas de pics de trafic. Au moment du lancement de la fonctionnalité, les programmeurs pourront sélectionner un modèle basé sur les États-Unis ou un modèle basé sur l'Union européenne, chacun incluant deux à trois régions prédéfinies à partir de ces emplacements géographiques. Actuellement, les modèles disponibles pour l'inférence inter-régions comprennent Claude 3.5 Sonnet, la famille Claude 3 de grands modèles de langage (LLM), à savoir Haiku, Sonnet et Opus.

Mise en garde sur la latence

AWS a indiqué que la fonctionnalité essaiera de servir toute demande à partir de la région primaire en premier avant de passer à une région secondaire, ce qui entraînera une latence supplémentaire lors du reroutage. « Au cours de nos tests, nous avons constaté une latence supplémentaire à deux unités en millisecondes », a écrit le fournisseur. Pour plus de clarté, les développeurs et les entreprises doivent payer le même prix par jeton pour les modèles individuels répertoriés par rapport à leur région principale ou source pour l'inférence inter-régions. Pour cette fonctionnalité, AWS a déclaré qu'elle ne facturerait pas aux utilisateurs professionnels le transfert de données, le chiffrement, l'utilisation du réseau et les différences potentielles de prix par million de jetons par modèle.

Par ailleurs, le fournisseur de services cloud a expliqué que les entreprises devaient porter une attention particulière à leurs exigences en matière de résidence des données et de protection de la vie privée. « Même si aucune donnée client n’est stockée dans la ou les régions primaires ou secondaires lors de l'utilisation de l'inférence inter-régions, il est important de tenir compte du fait que les données d'inférence seront traitées et transmises au-delà de la région primaire », a précisé l’entreprise. Outre AWS, Snowflake semble être le seul autre fournisseur de services LLM à avoir introduit l'inférence inter-régions. Au début du mois, Snowflake a livré la fonctionnalité dans le cadre de ses fonctions d'IA et de ML.

D'autre part, les fournisseurs de services cloud concurrents, comme Google Cloud et Microsoft, proposent des fonctionnalités similaires dans leurs bases de données, leur infrastructure et leurs services d'apprentissage machine plus anciens. Alors que Google Cloud propose des fonctionnalités similaires dans ses autres services comme Cloud Run et BigQuery, Microsoft offre des points de terminaison d'inférence en tant qu’option sans serveur via son service Azure Machine Learning. Concernant BigQuery, Google Cloud permet la réplication interrégionale des ensembles de données. De même, Azure offre aux entreprises la possibilité de répliquer les données entre les régions cloud.

Commentaire