De plus en plus d’entreprises travaillent sur des applications à base d’IA en s’appuyant sur différents modèles. Pour éviter les hallucinations et obtenir des réponses plus pertinentes, elles ont souvent recours au RAG (Retrieval Augmented Generation), une technique qui s’appuie sur des sources de connaissances externes. Elle est souvent en compétition avec le fine tuning et le prompt engineering pour limiter les hallucinations. Mais le RAG « est devenu une approche essentielle pour réduire les hallucinations dans les LLM et obtenir des résultats business à partir de l'IA générative », fait remarquer Charlie Dai, analyste principal chez Forrester. Nonobstant les entreprises sont à la recherche d’outils d’évaluation de leur initiative RAG d’où l’intérêt pour la récente annonce d’AWS.

Une méthode d’évaluation automatisée du RAG

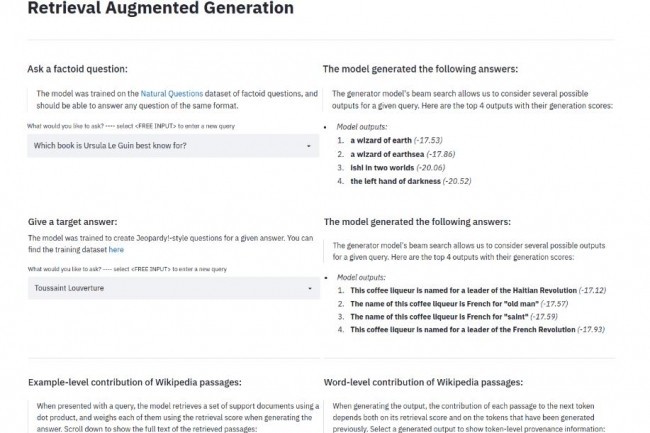

Intitulé « Automated Evaluation of Retrieval-Augmented Language Models with Task-Specific Exam Generation », l’article sera présenté lors de la conférence ICML 2024 en juillet. Il propose un processus de génération d'examen automatisé, amélioré par la théorie de la réponse à l'item (Item Response Theory, IRT), pour évaluer l'exactitude factuelle des modèles RAG sur des tâches spécifiques. Cette téhorie, également connue sous le nom de théorie de la réponse latente, est généralement utilisée en psychométrie pour déterminer la relation entre les caractéristiques non observables et celles observables, telles que les résultats ou les réponses, à l'aide d'une famille de modèles mathématiques. Selon les chercheurs d'AWS, l'évaluation de la RAG est réalisée en la notant sur un examen synthétique auto-généré composé de questions à choix multiples basées sur le corpus de documents associés à une tâche particulière.

« Nous nous appuyons sur la théorie de la réponse aux questions pour estimer la qualité d'un examen et sa valeur informative sur la précision spécifique à une tâche. L’IRT fournit aussi un moyen naturel d'améliorer l'examen de manière itérative en éliminant les questions de l'examen qui ne donnent pas suffisamment d’informations sur la capacité d'un modèle », ont déclaré les chercheurs. « Le processus d'évaluation du RAG a été testé sur quatre tâches de questions-réponses ouvertes basées sur des résumés Arxiv, des questions StackExchange, des guides de dépannage AWS DevOps et des documents de la Securities and Exchange Commission (SEC) », ont-ils expliqué, ajoutant que les expériences ont révélé des informations plus générales sur les facteurs ayant un impact sur les performances des RAG, comme la taille, le mécanisme de recherche, les prompts et le fine tuning

Une approche prometteuse

Selon Joe Regensburger, expert en IA de l'entreprise de sécurité des données Immuta, l'approche décrite dans l'article d'AWS présente plusieurs points prometteurs, notamment la possibilité de relever le défi des pipelines spécialisés nécessitant des tests spécialisés. « C'est un point essentiel, car la plupart des pipelines s'appuieront sur des LLM commerciaux ou open source prêts à l'emploi. Ces modèles n'auront pas été formés sur la base de connaissances spécifiques à un domaine, de sorte que les ensembles de tests conventionnels ne seront pas utiles », a expliqué le spécialiste. Toutefois, ce dernier précise que, même si l'approche est prometteuse, elle devra encore évoluer dans le domaine de la génération d'examens, car le plus grand défi n'est pas de générer une question ou la réponse appropriée, mais plutôt de générer des questions de distraction suffisamment stimulantes. « En général, les processus automatisés peinent à rivaliser avec les questions émises par l'homme, en particulier en ce qui concerne les questions distractives. En tant que tel, c'est le processus de génération de distracteurs qui pourrait bénéficier d'une discussion plus détaillée », a déclaré Joe Regensburger, en comparant les questions créées automatiquement avec celles élaborées par l'homme dans le cadre des examens AP (advanced placement).

Selon l’expert, les questions des examens AP sont posées par des experts en la matière qui continuent à poser des requêtes, à les réviser et à les répéter tout en préparant l'examen. Il est important de noter qu'il existe déjà des tests basés sur des examens pour les LLM. « Une partie de la documentation de ChatGPT mesure les performances du modèle par rapport à une batterie de tests standardisés », a rappelé Joe Regensburger, ajoutant que le document d'AWS étend la prémisse d'OpenAI en suggérant qu'un examen pourrait être généré par rapport à des bases de connaissances spécialisées, souvent privées. « En théorie, cela permettra de voir comment un pipeline RAG pourrait se généraliser à des connaissances nouvelles et spécialisées. Parallèlement, Bradley Shimmin, analyste en chef d'Omdia a souligné que plusieurs fournisseurs, dont AWS, Microsoft, IBM et Salesforce, proposent déjà des outils ou des frameworks axés sur l'optimisation et l'amélioration des implémentations RAG, qui vont d'outils d'automatisation de base comme LlamaIndex à des outils avancés comme GraphRAG, récemment lancé par Microsoft.

Une optimisation des ressources et des coûts

Le choix des bons algorithmes de recherche conduit souvent à des gains de performance plus importants que la simple utilisation d'un LLM plus grand, cette dernière approche pouvant s'avérer coûteuse, soulignent les chercheurs d'AWS dans l'article. « Même si des progrès récents dans la « mise en cache du contexte » avec Gemini Flash de Google par exemple, évitent aux entreprises de construire des processus complexes et délicats de tokenization, de chunking et de récupération dans le cadre du pipeline RAG, cette approche peut entraîner un coût élevé en ressources informatiques d'inférence pour éviter la latence », a tempéré le consultant d'Omdia.

« Des techniques telles que la théorie de la réponse à l'item d'AWS promettent d'aider à résoudre l'un des aspects les plus délicats du RAG, à savoir la mesure de l'efficacité des informations récupérées avant de les envoyer au modèle », a poursuivi l’analyste, ajoutant qu'avec de telles optimisations à portée de main, les entreprises peuvent mieux optimiser leur surcharge d'inférence en envoyant les meilleures informations à un modèle plutôt que de tout lui envoyer en une seule fois.

Commentaire