Annoncées lors de la conférence annuelle re:Invent organisée cette semaine (2 au 6 décembre) par AWS, les fonctionnalités de Bedrock doivent aider les entreprises à rationaliser les tests d'applications IA avant leur déploiement. La mise à jour inclut un outil d'évaluation RAG (retrieval augmented generation ou génération augmentée de récupération) au sein Knowledge Bases généralement utilisées par les entreprises pour exploiter leurs propres données afin de fournir plus de contexte aux LLM et obtenir de meilleures réponses de leur part. Les entreprises peuvent aussi s’en servir pour mettre en œuvre l'ensemble du flux RAG d'une application, depuis l'ingestion jusqu’à l'extraction et l'augmentation de la demande, sans avoir à construire des intégrations personnalisées en fonction des sources de données et à gérer les flux de données.

« Il est désormais possible d’exécuter une évaluation automatique de la base de connaissances pour évaluer et optimiser les applications RAG à l'aide des Knowledge Bases », a écrit le fournisseur dans un billet de blog, ajoutant que le processus d'évaluation faisait intervenir un LLM pour le calcul des métriques de l'évaluation. Selon AWS, les évaluations RAG amène à comparer différentes configurations et ajuster leurs paramètres afin d'obtenir les résultats dont elles ont besoin pour leur cas d’usage. « Pour effectuer ces évaluations, les utilisateurs peuvent passer par la console Bedrock et choisir « Evaluations » après avoir navigué dans la section « Inference and Assessment » de la console », a indiqué l'entreprise. Cette fonctionnalité est actuellement disponible en avant-première.

Des connecteurs personnalisés

AWS a également annoncé la prise en charge de connecteurs personnalisés et la possibilité de reclasser les modèles dans Knowledge Bases. Les connecteurs facilitent l'ingestion de données provenant de sources diverses, y compris celle en continu dans les bases de connaissances de Bedrock. « Les développeurs peuvent désormais ingérer, mettre à jour ou supprimer des données de manière efficace et rentable à partir d’un seul appel API, sans avoir à effectuer une synchronisation complète avec la source de données périodiquement ou après chaque changement », a expliqué le fournisseur. Sans ce support des connecteurs personnalisés, les entreprises devraient déplacer leurs données vers une source prise en charge par AWS, comme S3. Ces composants sont disponibles et ils sont accessibles via la console Bedrock et le kit de développement logiciel (SDK) d'AWS.

Par ailleurs, AWS a introduit l’API Rerank dans les Knowledge Bases. Grâce à cet outil, les développeurs peuvent exploiter des modèles de reclassement dynamique, ou reranking, pour rendre leurs applications basées sur RAG plus performantes. Cela améliore la pertinence et la précision des réponses et de réduire les coûts. Selon AWS, les modèles de reclassement dynamique accessibles via la nouvelle API pourraient aider les développeurs à surmonter les limites de la recherche sémantique, qui intervient souvent dans les applications RAG. L'incapacité à hiérarchiser les documents les plus appropriés en fonction des préférences de l'utilisateur ou du contexte de la requête, en particulier lorsque la requête est complexe, ambiguë ou qu'elle implique un contexte nuancé, est l’une de ces limites. « Cela peut conduire à la récupération de documents qui ne sont que partiellement pertinents par rapport à la question de l'utilisateur », a précisé l'entreprise, ajoutant que la récupération de documents partiellement pertinents peut poser un autre défi lié à l'attribution correcte des sources. À ce jour, l'API prend en charge les modèles Amazon Rerank 1.0 et Cohere Rerank 3.5.

Un LLM-as-a-judge dans Bedrock Model Evaluation

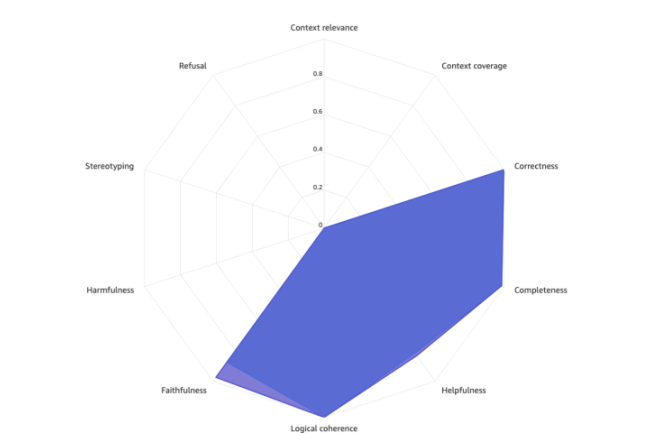

Le fournisseur de cloud a également ajouté la fonctionnalité de LLM référent « LLM-as-a-judge » au modèle d’évaluation de Bedrock. Cet outil d’évaluation peut aider les entreprises à choisir un LLM qui correspond à leur cas d’usage. La fonctionnalité LLM-as-a-judge, actuellement disponible en avant-première, donnera aux développeurs la capacité d'effectuer des tests et d'évaluer d'autres modèles avec une qualité similaire à celle d'un humain, à un coût inférieur à celui d'un humain. « Grâce à LLM-as-a-judge, les entreprises peuvent passer plus facilement à la production en fournissant une évaluation rapide et automatisée des applications alimentées par l'IA, en raccourcissant les boucles de rétroaction et en accélérant les améliorations », a affirmé AWS. Les évaluations portent sur plusieurs aspects qualitatifs, notamment l'exactitude, l'utilité et sur des critères de l'IA responsable comme le refus de réponse et la nocivité.

Commentaire