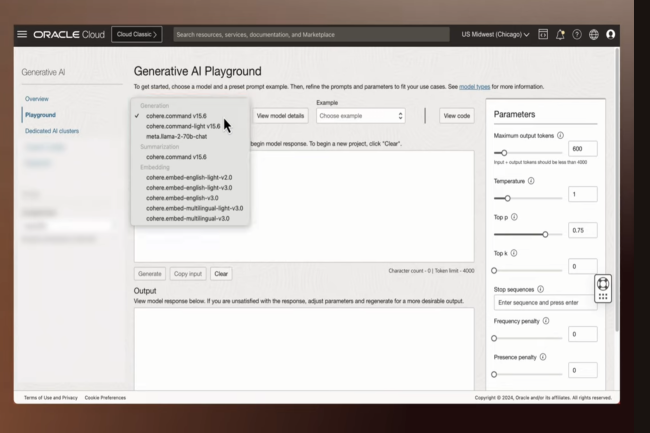

En septembre dernier, Oracle a dévoilé sa stratégie en matière d’IA générative en lançant en version beta le service OCI Generative AI. Aujourd’hui, la firme de Redwood Shores annonce que cette offre sur son cloud public est maintenant disponible pour tous avec quelques évolutions. Parmi les améliorations, la solution supporte des modèles d’IA supplémentaires. Ainsi, elle accueille le LLM de Meta Llama2 70B (modèle optimisé par la génération de texte dans le cadre de chat) et aussi les modèles de Cohere comme Command, Summarize et Embed. Ils sont disponibles en mode managé via des appels API.

L’agent RAG pour contextualiser l’IA générative

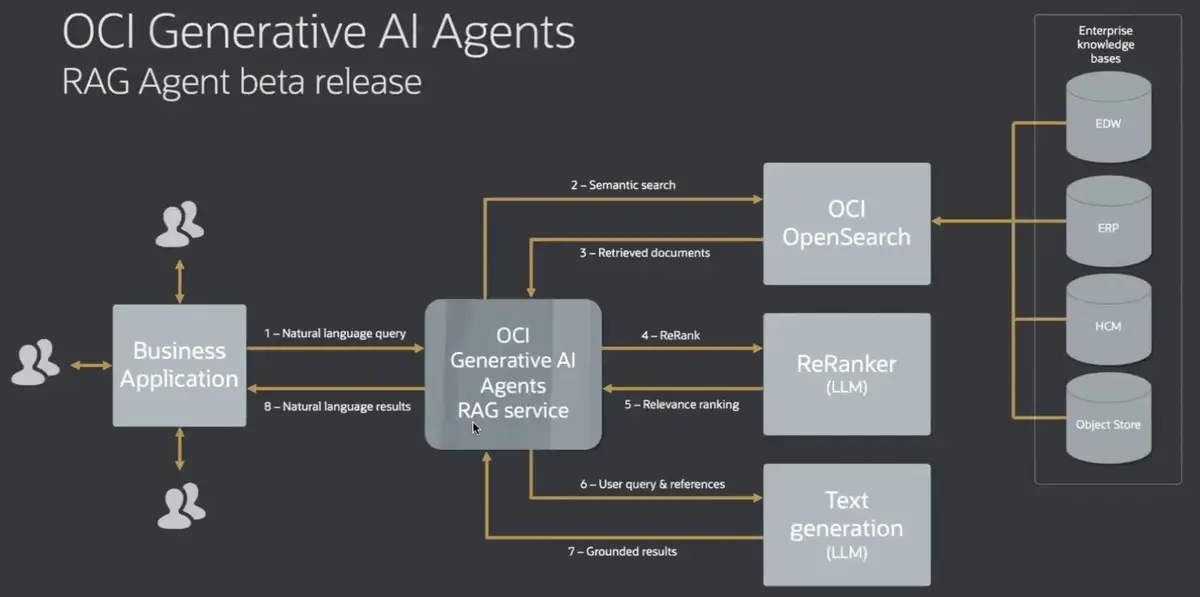

En plus des LMM, Oracle a ajouté une panoplie d’agents à base IA pour aider les entreprises à tirer le meilleur parti de leurs données d'entreprise tout en utilisant de grands modèles de langage et en construisant des applications génératives basées sur l'IA. Le premier de ces agents est dédié au RAG (retrieval augmented generation). Cette technique complète la génération de texte (LLM) avec des informations provenant de sources de données privées ou propriétaires. « Cet agent, qui fonctionne comme LangChain, combine la puissance des LLM et la recherche basée sur OCI OpenSearch, pour fournir des résultats contextualisés et améliorés avec les données de l’entreprise ». a déclaré Vinod Mamtani, vice-président des services d'IA générative d'OCI.

Oracle a présenté son agent dédié à la technologie RAG. (Crédit Photo : Oracle)

Concrètement quand un utilisateur lance une requête en langage naturel dans l’agent RAG via une application métier, la demande est transmise à OCI OpenSearc. Ce dernier, qui est une forme de recherche vectorielle ou sémantique, lit et collecte les informations pertinentes à partir du référentiel de données de l’entreprise. Les résultats de la recherche sont ensuite classés par un LLM ReRanker, qui transmet le classement à un LLM de génération de texte, qui répond à la requête en langage naturel. « Les informations extraites sont à jour - même avec des datawarehouse dynamiques - et les résultats sont fournis avec des références aux données sources originales », a expliqué Vinod Mamtani. Les prochaines mises à jour de l'agent RAG, qui devraient être publiées au cours du premier semestre 2024, prendront en charge un plus large éventail d'outils de recherche et d'agrégation de données et donneront également accès à Oracle Database 23c avec AI Vector Search et MySQL Heatwave avec Vector Store.

Un effort vers la personnalisation

D'autres fonctionnalités, qui seront également disponibles à la même période, incluent la possibilité de créer un agent AI à partir de la console OCI. Un utilisateur pourra construire un bot en spécifiant la tâche dont il a besoin et en l'attachant à une source de données, indique le responsable. Selon Oracle, ces agents sont élaborés à l'aide des travaux sur ReAct publiés par des chercheurs de l'université de Princeton et de Google. A partir de ce framework, ils sont capables de raisonner, agir et planifier sur la base d'une série de pensées, d'actions et d'observations.

Selon Vinod Mamtani, ces capacités proposeront aux agents d'aller au-delà des tâches de recherche d'informations et d'appeler des API au nom de l'utilisateur, ainsi que d'en automatiser d'autres. L'éditeur prévoit également d'ajouter au service des agents multi-tâches à qui l'on peut demander de conserver la mémoire des interactions passées afin d'enrichir encore le contexte du modèle et ses réponses. Selon l'entreprise, la plupart de ces agents et de leurs actions peuvent être ajoutés à sa suite d'applications SaaS, notamment Fusion Cloud Applications Suite, NetSuite et des applications sectorielles telles que Cerner. Enfin, la firme américaine a présenté en version beta le service AI Quick Actions dans OCI Data Science. Cette fonctionnalité propose des capacités de low-code pour accéder à plusieurs LLM open source.

Oracle sur la bonne voie selon les analystes

Après les annonces, nos confrères d’IDG ont demandé leur avis à des analystes. Pour Ron Westfall, directeur de recherche chez The Futurum Group, « Oracle peut offrir aux entreprises une approche plus rationalisée pour réduire les dépenses et les ressources ou le temps consacrés au pré-entraînement, au réglage fin et à l'entraînement continu de grands modèles de langage (LLM) sur les connaissances ou les données d'une entreprise, ce qui s'est avéré être un obstacle dans de nombreux environnements d'entreprise actuels, à l'exception de certains centres d'appels et applications de soutien à l'expérience client ».

De son côté, Bradley Shimmin, analyste en chef du cabinet de recherche Omdia, estime que la firme « tente d'intégrer des éléments fondamentaux de l'IA générative dans ses offres de base, en particulier les bases de données, afin d'optimiser les ressources de calcul et de réduire les coûts ». Il constate aussi que, « c'est une chose de construire un pipeline de récupération et de génération augmentée (RAG) de base capable d'indexer quelques PDF pour soutenir un LLM à utilisateur unique, c'est un tout autre défi de mettre en œuvre le RAG pour des pétaoctets de données d'entreprise en constante évolution, et de fournir des informations à partir de ces données au public en moins d'une milliseconde ». Mais Andy Thurai, analyste principal chez Constellation Research, est un peu plus critique en estimant qu’Oracle est « loin derrière » ses rivaux lorsqu’on les compare sur la base des offres globales d’IA générative. « L'option d'Oracle consistant à fournir un service hébergé en fonction des besoins est en concurrence avec l'offre beaucoup plus puissante d'AWS, qui propose davantage d'options et de fonctions que l'offre d'OCI », observe-t-il. Tout en remarquant qu’Oracle manque de LLM dans son catalogue et leur utilisation est limitée par rapport à la concurrence.

Commentaire