« Simplifier et mettre à l'échelle le développement, l'opérationnalisation et la consommation de modèles ML au sein de l'entreprise ; donner vie à l'IA et aux ML avec des expériences familières pour les développeurs ; mettre l’IA générative dans la main de chaque utilisateur pour obtenir rapidement et en toute sécurité de la valeur à partir des données de l'entreprise ; élargir la portée des charges de travail exécutées dans Snowflake - construire dans n'importe quel langage, obtenir une flexibilité d'instance, y compris avec les GPU, et exécuter en toute sécurité des services tiers de premier plan ». Voilà en quelques lignes les objectifs visés par Snowflake.

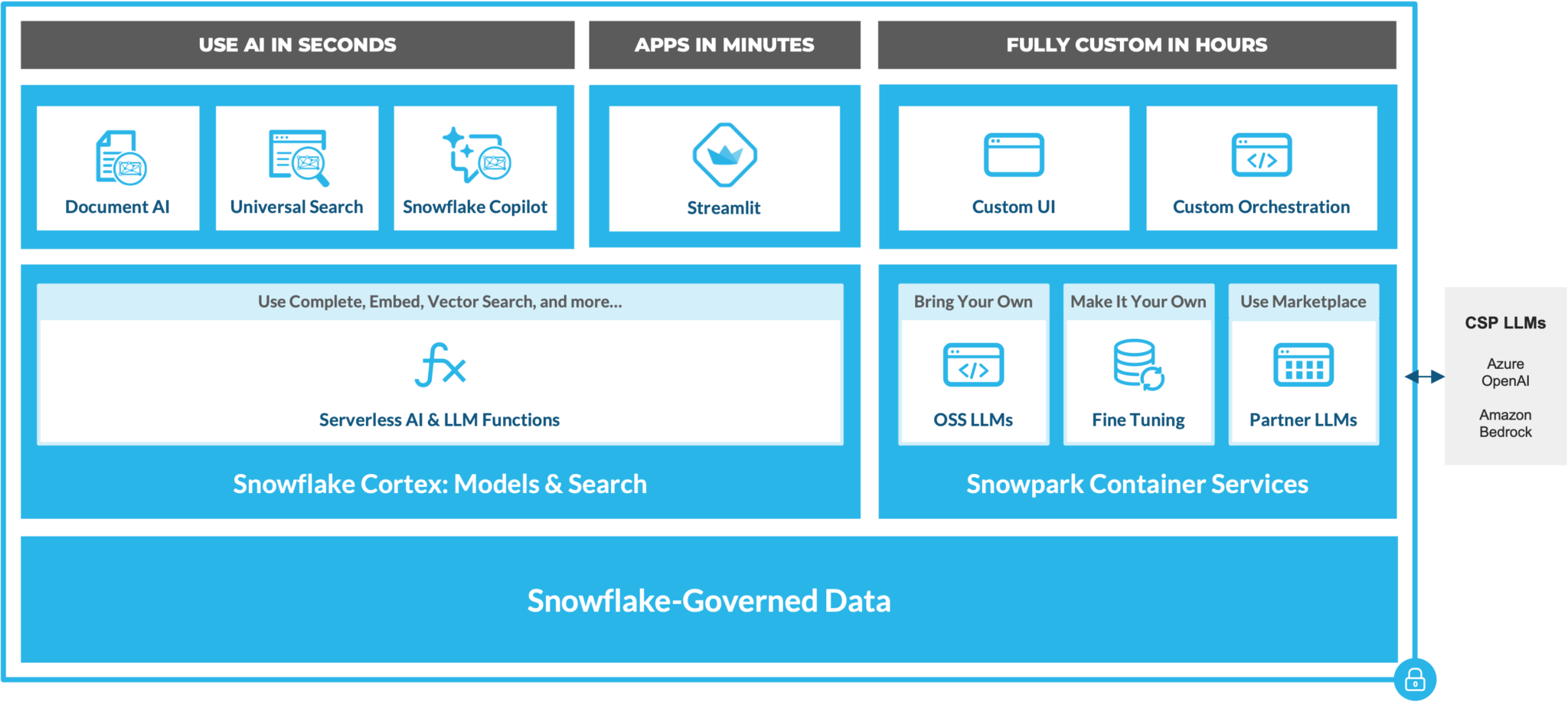

Sa plateforme, qui s’articule de plus en plus autour de l’IA générative et des LLM intègre désormais des solutions autour du développement et des opérations ML de bout en bout - notamment grâce à l’API de modélisation ML Snowpark (bientôt disponible pour tous), Feature Store (en beta privée) et Snowpark Container Services (bientôt en beta publique) – ainsi qu’une solution dédiée à l’expérience des développeurs – Notebooks (en beta privée). Une plateforme fait également son apparition pour les LLM et l’IA générative. Baptisée Cortex, elle proposera bientôt des fonctions spécialisées et des fonctions générales. Enfin, Snowflake multiplie les solutions alimentées par LLM ; on connaissait déjà Document AI introduit en juin dernier, il est désormais rejoint par Copilot et Universal Search, deux services eux aussi en beta privée.

Un aperçu des fonctionnalités d'IA générative et LLM dans Snowflake. (Crédit : Snowflake)

Zoom sur Cortex, un service dédié à l’IA

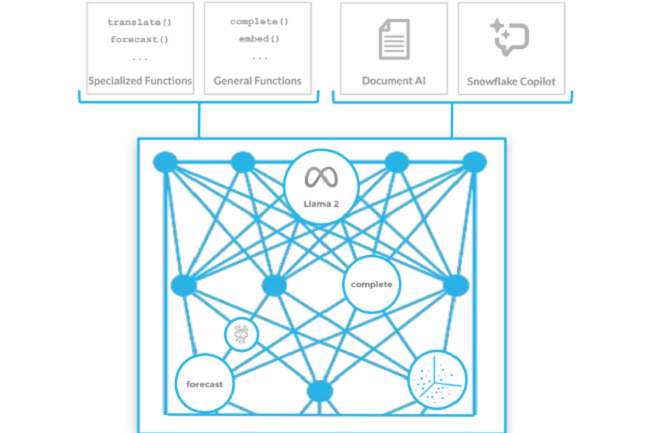

« Un service entièrement géré qui héberge des modèles d'IA, des LLM et des fonctions vectorielles à la pointe de l'art ». Selon Sridhar Ramaswamy, ancien de Neeva (racheté par Snowflake en mai 2023) et dont le titre est senior vice-président de l’IA, Cortex – actuellement en private preview – fournit aux entreprises les éléments de base nécessaires pour utiliser les LLM et l'IA sans nécessiter aucune expertise dans la gestion d'une infrastructure complexe basée sur GPU. Le service managé comprend également des fonctions serverless, qui peuvent être appelées à l'aide de code SQL ou Python, pour garantir que les utilisateurs de tout niveau de compétences peuvent accéder à ces fonctions pour analyser des données ou créer des applications basées sur l'IA, ajoute-t-il. « Pour tout texte d'entrée donné, ces modèles peuvent détecter les sentiments, extraire une réponse, résumer le texte et le traduire dans une langue sélectionnée », a déclaré la société. Elle ajoute que les fonctions existantes basées sur le ML, telles que les prévisions, la détection d'anomalies et un explorateur de contributions et de classification sont également disponibles.

D'autres services également inclus à Cortex, comprennent un modèle texte-vers-SQL et une intégration vectorielle, ainsi qu'une fonction de recherche basée sur ses propres modèles de base et modèles open source. Cortex constitue, pour Snowflake, un moyen d’apporter aux entreprises une offre rationalisant le développement d'applications, des cas d'usage, de modèles d'IA et de ML et de modèles de base de Snowpark. Un moyen également de répondre à la concurrence, à savoir AWS RedShift, Google BigQuery et ClearScape Analytics de Teradata.

Recherche universelle et assistant dopé à l’IA parmi les nouveautés

La firme indique par ailleurs que « Cortex apporte de puissantes capacités d'IA et de recherche sémantique à la plateforme Snowflake ». Il s’agit de trois fonctions supplémentaires actuellement en beta privée : Document AI (qui n’est plus à présenter), Universal Search et Copilot – qui utilisent toutes des LLM open source ou des LLM propriétaires de Snowflake comme socle. Avec Universal Search, les utilisateurs ont accès à une recherche alimentée par LLM offrant un accès rapidement aux données et aux applications. Construit sur la technologie de moteur de recherche acquise auprès de Neeva, Universal Search aide par exemple à trouver des objets de base de données dans son compte Snowflake. « Avec la version initiale, vous pourrez trouver des tables, des vues, des bases de données, des schémas, des produits de données du Marketplace et des articles de la documentation Snowflake » détaille la firme.

De son côté, Copilot (encore un) est un assistant alimenté par LLM pour générer et affiner des requêtes SQL en langage naturel. Par exemple, les analystes peuvent poser une question à Copilot, qui écrira une requête SQL en utilisant les tables pertinentes. Les utilisateurs peuvent également affiner les requêtes au cours de la conversation pour filtrer les informations les plus pertinentes pour la tâche. Aucune configuration n'est nécessaire. En outre, cette fonction de conversion de texte en code sera bientôt programmée via une fonction générale, Text2SQL, avec Cortex, précise Snowflake. Notons que ce Copilot tire également parti de la recherche universelle pour identifier les tables et les colonnes pertinentes pour la génération SQL.

Exemple d'utilisation de Copilot de Snowflake. (Crédit : Snowflake)

Interfaces de développement et fonctions de ML pour Snowpark

En parallèle de ces annonces, Snowflake a dévoilé des outils, pour la plupart en avant-première, comprenant Notebooks, Snowpark ML Modelling API et Snowpark ML Operations. Notebooks est un ensemble d’interfaces de développement qui offre un environnement de programmation interactif, basé sur des cellules, compatible avec Python et SQL. « Les Notebooks intégrés de Snowflake proposent aux développeurs d'écrire et d'exécuter du code, d'entraîner et de déployer des modèles à l'aide de Snowpark ML, de visualiser les résultats à l'aide d'éléments graphiques Streamlit, entre autres cas d'utilisation », a déclaré la société.

L'API de modélisation ML de Snowpark aide quant à elle les développeurs et datascientists à étendre l'ingénierie des fonctionnalités et à simplifier l'entraînement des modèles en mettant en œuvre des frameworks d'IA et de ML nativement sur les données dans Snowflake. Par ailleurs, l’éditeur ajoute des fonctions à Snowpark ML Operations, notamment une mise à jour de Model Registry et Feature Store intégré, qui crée, stocke, gère et sert des fonctionnalités d'apprentissage automatique pour l'entraînement et l'inférence de modèles. À noter que le Feature Store est actuellement en avant-première privée.

Enfin, pour pousser à davantage d’automatisation dans les opérations de développement pour les applications et les pipelines de données, la société ajoute une fonctionnalité, baptisée Database Change Management, qui devrait bientôt être disponible en test. « Grâce à cette fonction, les développeurs peuvent coder de manière déclarative et facilement modéliser leur travail pour gérer les objets Snowflake dans plusieurs environnements », est-il précisé.

Commentaire