La genAI et les hallucinations vont de pair, quelle que soit la qualité de l'entraînement des grands modèles de langage qui sous-tendent les outils d'intelligence artificielle générative. C'est pourquoi Microsoft a dévoilé ce mardi Correction, une fonctionnalité de son outil Azure AI Content Safety qui, selon elle, repère, puis corrige, les réponses de la genAI qui ne sont pas directement liées aux sources de données utilisées pour former un LLM - en d'autres termes, les hallucinations. « Permettre à nos clients de comprendre et d'agir sur les contenus non fondés et les hallucinations est crucial, d'autant plus que la demande de fiabilité et de précision dans les contenus générés par l'IA continue d'augmenter », a fait savoir Microsoft dans un billet de blog.

Si les « outils complémentaires » peuvent aider à vérifier l'exactitude des résultats du LLM, Gartner a constaté que l'utilisation de meilleures techniques de recherche en génération augmentée de récupération (RAG) devrait être une première étape pour atténuer les hallucinations. « Nous conseillons aux clients d'utiliser la recherche pour fournir des informations fixant la réponse LLM dans le contexte de l'entreprise », a déclaré Jason Wong, analyste et vice-président distingué de Gartner. Le RAG est une méthode créant un modèle de genAI plus personnalisé grâce à une série de questions et de réponses fournies à un LLM, ce qui permet d'apporter des réponses plus précises et plus spécifiques aux requêtes.

Compatible avec Llama et GPT-4o

Outre Google, un certain nombre de start-ups et d'autres fournisseurs de services cloud ont proposé des outils pour surveiller, évaluer et corriger les problèmes liés aux résultats de la genAI dans l'espoir d'éliminer les problèmes systémiques. Correction fait partie de plusieurs mises à jour dans Azure AI Studio, un outil d'évaluation des risques, et aussi d'Hybrid Azure AI Content Safety (AACS) un SDK intégré pour le traitement de l'IA. Cet outil est disponible dans le cadre de l'API Azure AI Content Safety actuellement en bêta et peut être utilisé avec n'importe quel modèle genAI basé sur le texte, y compris Llama de Meta et GPT-4o d'OpenAI. Les analystes sont toutefois sceptiques quant à l'efficacité de Correction pour éliminer les erreurs. « Les hallucinations continuent d'entraver la mise en œuvre de l'IA générative », a déclaré M. Wong. « Tous les hyperscalers ont lancé des produits pour atténuer les hallucinations, mais aucun ne promet de les éliminer complètement ou même d'atteindre certains seuils de précision. »

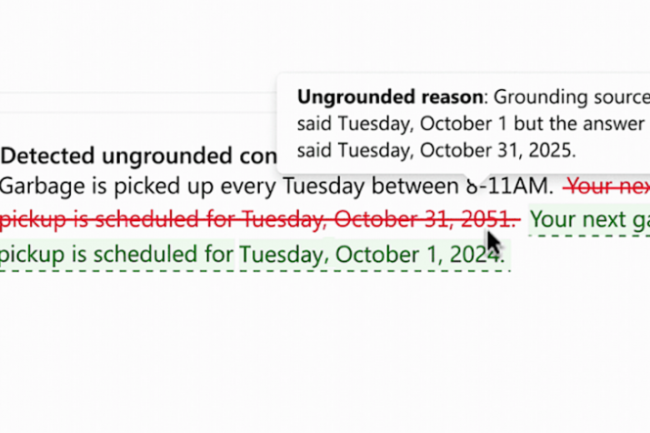

Microsoft a présenté pour la première fois Correction en mars. Pour l'utiliser, une application genAI doit se connecter à des documents de base, qui sont utilisés dans les scénarios de résumé de documents et de questions-réponses basés sur le RAG, a indiqué Microsoft. Depuis lors, les clients demandent ce qu'ils peuvent faire une fois que des informations erronées sont détectées, à part les bloquer. « Cela met en évidence un défi important dans le paysage de l'IA générative qui évolue rapidement, où les filtres de contenu traditionnels sont souvent insuffisants pour répondre aux risques uniques posés par les hallucinations de l'IA générative », a écrit Katelyn Rothney, responsable principale du marketing des produits chez Microsoft, dans un billet de blog. S'appuyant sur le système de détection de l'ancrage existant, l'outil de correction permet à Azure AI Content Safety d'identifier et de corriger les hallucinations en temps réel, avant que les utilisateurs des applications d'IA générative ne les rencontrent. L'outil fonctionne en signalant d'abord le contenu non fondé. Ensuite, le système Azure Safety lance un processus de réécriture en temps réel pour réviser les parties inexactes et assurer l'alignement avec les sources de données connectées.

Eliminer les hallucinations, mission impossible ?

« Cette correction a lieu avant que l'utilisateur ne puisse voir le contenu initial infondé », a déclaré M. Rothney. « Enfin, le contenu corrigé est renvoyé à l'utilisateur. La nature hallucinatoire de la technologie genAI, comme GPT-4 d'OpenAI, Llama 2 de Meta et PaLM 2 de Google, est due au fait que leurs modèles fondamentaux sont basés sur des paramètres ou des options massifs, amorphes et non spécifiques à partir desquels l'algorithme peut choisir des réponses. Si la genAI est le plus souvent très précise dans ses réponses aux requêtes, elle est également encline à recueillir des informations là où elle n'était pas censée aller, juste pour pouvoir fournir une réponse, n'importe quelle réponse.

En fait, les LLM s'apparentent à des "perroquets stochastiques" - à mesure qu'ils grandissent, ils deviennent plus aléatoires dans leurs réponses conjecturales ou aléatoires. En fait, les « moteurs de prédiction du mot suivant » continuent simplement à répéter ce qu'on leur a appris, mais sans cadre logique. Une étude réalisée cette année par l'université de Stanford a révélé que la genAI commettait des erreurs lorsqu'elle répondait à des questions juridiques dans 75 % des cas. « Par exemple, dans une tâche mesurant la relation de précédent entre deux affaires [judiciaires] différentes, la plupart des LLM ne font pas mieux que de deviner au hasard ». L'optimisation de l'infrastructure de recherche en incorporant la recherche lexicale et sémantique augmente la probabilité que seules les informations pertinentes soient transmises au LLM, a déclaré M. Wong. « Bien que cela puisse réduire de manière significative la probabilité d'hallucinations, cela ne peut pas les éliminer », a-t-il ajouté. « La qualité de l'information récupérée pour le RAG détermine largement la qualité du résultat, ce qui rend la gestion et la gouvernance du contenu essentielles comme point de départ pour minimiser les hallucinations.

Commentaire