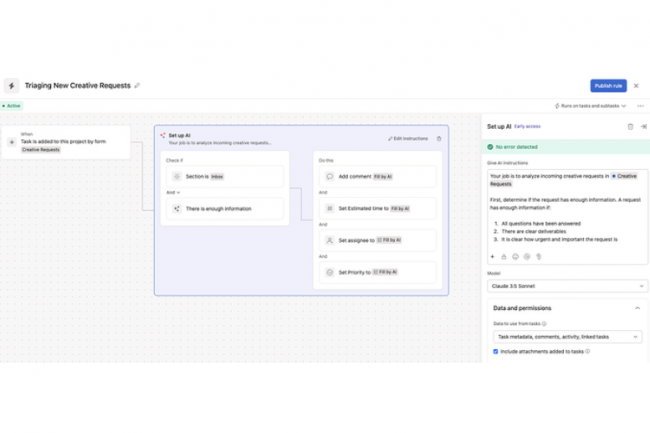

Appelé AI Studio, l’outil no-code lancé par Asana, permet de construire des agents conversationnels basés sur la GenAI pour automatiser les tâches de planification dans l’environnement de travail. Lors du dévoilement du projet en juin, le fournisseur avait promis d’apporter aux clients des capacités de conception d’agents autonomes pour effectuer des tâches indépendantes dans son logiciel éponyme. Hier, Asana a déclaré que le constructeur d'agents d'IA, rebaptisé AI Studio, est désormais sorti de la phase bêta et disponible pour ses clients Enterprise et Enterprise+ en accès anticipé. À ce stade, AI Studio est proposé soit via un abonnement gratuit avec des limites quotidiennes d'utilisation, soit sous forme de module complémentaire payant. Pour l’instant, Asana ne souhaite pas communiquer sur les tarifs.

« Les clients qui ont pu tester la version bêta d’AI Studio ont trouvé que le déploiement d'agents d'IA présentait plusieurs avantages », a déclaré Paige Costello, responsable de l'IA chez Asana. « Ils mentionnent en particulier la rapidité de la prise de décision, l'accélération générale du travail et la réduction des tâches administratives et de la charge de travail », a-t-elle détaillé. « Le potentiel des agents basés sur l'IA pour accélérer le flux de travail est énorme », a estimé Wayne Kurtzman, vice-président de la recherche couvrant le social, les communautés et la collaboration chez IDC. « La possibilité de déployer des agents dans le flux de travail, là où les équipes travaillent, sans code de surcroit, représente une offre à forte valeur », a-t-il ajouté.

4 LLM d'Anthropic et d'OpenAI derrière les agents

À l'occasion de ce lancement, Asana a également annoncé des fonctionnalités supplémentaires pour AI Studio, notamment une plus grande variété d'actions pour l'agent d'IA, un meilleur contrôle des capacités de traitement des workflows et un élargissement du contexte auquel l'agent d'IA peut se baser dans sa prise de décision. Les utilisateurs peuvent aussi consulter l'historique des actions et des décisions de l’agent d'IA concerné. « Il est possible de passer en revue tout le travail effectué et de comprendre pourquoi l'agent personnalisé que l’on a construit a fait un choix spécifique et d'annuler la décision de l’agent », a expliqué Mme Costello.

Les utilisateurs ont le choix entre quatre modèles de langage pour alimenter les agents d'IA : Claude 3.5 Sonnet et Claude 3 Haiku d'Anthropic, et GPT-4o et GPT-4o mini d'OpenAI. Les agents d'IA étant capables d'accomplir des tâches de manière autonome, la propension des modèles de langage à « halluciner » et à fournir des résultats inexacts pourrait inquiéter les entreprises. Mais Mme Costello a précisé qu'il existait des garanties pour réduire la probabilité que les agents d'IA génèrent et agissent sur la base d'informations incorrectes, et elle a affirmé que les concepteurs de ces flux de travail de l'IA « restaient aux commandes ». Par exemple, un utilisateur peut exiger qu'un agent d'IA demande l'approbation d'un humain avant d'effectuer des actions jugées plus risquées, comme l'envoi d'un courriel externe à un client. « Les utilisateurs sont les décideurs, et ce sont eux qui sont responsables du travail en dernier ressort », a insisté Mme Costello.

De son côté Margo Visitacion, vice-présidente et analyste principale chez Forrester, chargée du développement et de la fourniture d'applications, a précisé : « Les entreprises commencent tout juste à adopter des agents d'IA, mais cette adoption s'accélère. Pour que les déploiements réussissent, il faudra expérimenter, échouer rapidement et tirer les leçons de ces expériences. Il faut un bon niveau de supervision, se concentrer sur les problèmes et recueillir des retours d’expérience pour s'assurer que l'on utilise le bon modèle qui répond à ses besoins. »

Commentaire