Anthropic ne perd pas de temps. Une poignée de mois après avoir lancé ses modèles Claude 3, le spécialiste en modèles de langage et agents conversationnels GenAI, annonce déjà un successeur pour son itération Sonnet. Annoncé en même temps que Claude 3 Haiku et Opus, Sonnet ce situe à mi-chemin en termes de performances et de coût. Mais avec la v3.5 qui vient d'être annoncée, ses capacités de traitement s'avèrent décuplées. Car Claude 3.5 Sonnet fonctionne deux fois plus vite que Claude 3 Opus pour un coût moindre et s'avère taillé pour répondre à des tâches complexes telles que le support client contextuel et l'orchestration de workflows à plusieurs niveaux.

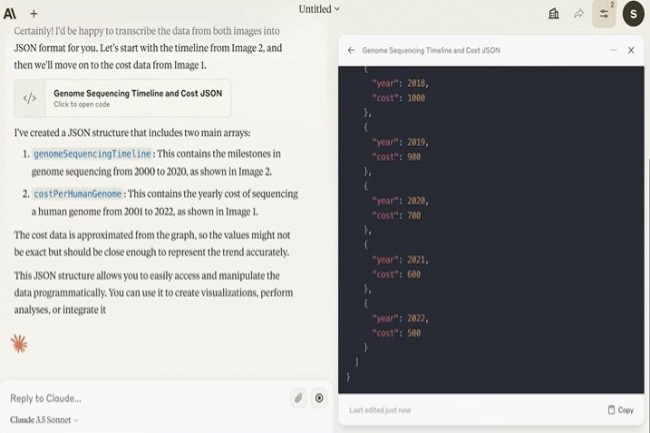

Claude 3.5 Sonnet est un LLM disposant de capacités pointues en matière de compréhension et d'analyse d'images (vision) et dépasse Claude 3 Opus dans ces tests standards. "Ces améliorations sont particulièrement remarquables pour les tâches qui requièrent un raisonnement visuel, comme l'interprétation de tableaux et de graphiques", précise l'éditeur. Mais Claude 3.5 Sonnet peut également transcrire avec précision du texte à partir d'images imprécises, ce qui peut s'avérer utile pour répondre à des cas d'usage en vente au détail, logistique et services financiers par exemple où l'IA peut tirer davantage d'informations d'une image, d'un graphique ou d'une illustration que d'un texte seul.

Aussi adapté pour la mise à jour de code

"Claude 3.5 Sonnet a résolu 64% des problèmes, surpassant Claude 3 Opus qui en a résolu 38%", annonce Anthropic. "Lorsqu'il reçoit les instructions et les outils nécessaires, Claude 3.5 Sonnet peut écrire, éditer et exécuter du code de manière autonome avec des capacités de raisonnement et de dépannage sophistiquées. Il gère les traductions de code avec facilité, ce qui le rend particulièrement efficace pour la mise à jour d'applications existantes et la migration de code de base."

Claude 3.5 Sonnet est maintenant disponible gratuitement sur Claude.ai et l'application Claude iOS, mais seuls les abonnés aux plans Claude Pro et Team bénéficient des capacités de requêtes les plus élevées. Il est également disponible via l'API Anthropic, Amazon Bedrock et Vertex AI de Google Cloud. Ce LLM coûte 3 $ par million de jetons d'entrée et 15 $ par million de jetons de sortie avec une fenêtre contextuelle de 200 000 jetons.

Commentaire