Flux RSS

Décisionnel

626 documents trouvés, affichage des résultats 1 à 10.

| Les 10 documents suivants > |

(21/02/2013 09:43:12)

Annuels Capgemini 2012 : le cap des 10 milliards d'euros franchi

Dans la foulée de la fermeture de la bourse, Capgemini a annoncé hier soir des résultats financiers annuels jugés plutôt satisfaisants par Paul Hermelin, son PDG. Le chiffre d'affaires de la SSII française a dépassé en 2012 la barre des 10 milliards d'euros, à 10,3 Md€, avec une croissance de 5,9% à taux de change et périmètre courants, qui se limite toutefois à 1,2% à taux de change et périmètre constants. Malgré le fait que la demande se soit un peu ralentie sur l'année, « les résultats sont en avance par rapport à nos guidances et au consensus des analystes », a fait remarquer le dirigeant. La marge opérationnelle est elle aussi au-dessus des engagements, à 7,7% du chiffre d'affaires malgré les difficultés de la filiale néerlandaise (et à 8% avant amortissement des actifs incorporels liés aux acquisitions). Le quatrième trimestre a été un peu moins bon, mais le ratio prises de commandes sur chiffre d'affaires y a atteint 1,16 (contre 1,07 sur l'année).

Paul Hermelin met par ailleurs en avant le montant de la trésorerie nette qui s'élève à 872 millions d'euros au 31 décembre 2012, soit plus du double qu'un an plus tôt. « Cela s'explique par une très bonne génération de free cash flow au 2e semestre, de 496 M€ », a indiqué le dirigeant. Un résultat dû aux paiements anticipés de clients anglo-saxons au 2ème semestre à hauteur d'environ 100 M€. « Fort de cette belle performance, le dividende est maintenu à un euro par action, au même niveau qu'en 2011 », a précisé le PDG.

Quatre axes pour 2013 : cloud, CRM axé social, big data, mobilité

Sur 2013, Capgemini va poursuivre l'enrichissement de son portefeuille d'offres dans quatre domaines : l'orchestration des services cloud, la transformation de l'expérience client avec les outils de réseaux sociaux, la Business Intelligence avec un axe big data (en 2012, la SSII a généré 500 M€ avec la BI, soit +16%) et la mobilité, notamment avec l'offre co-développée avec SAP.

Le groupe français constate une demande des clients européens sur les services offshore. « Nous appliquons les mêmes méthodes de travail onshore et offshore », a souligné Paul Hermelin, avant de rappeler la très bonne position de Capgemini sur le test applicatif et de citer parmi les clients importants gagnés en 2012 à l'international le ministère américain de la sécurité intérieure. Il y a davantage de contrats globaux sur lesquels « Capgemini est capable de suivre ses clients mondiaux », a par ailleurs indiqué hier Paul Hermelin.

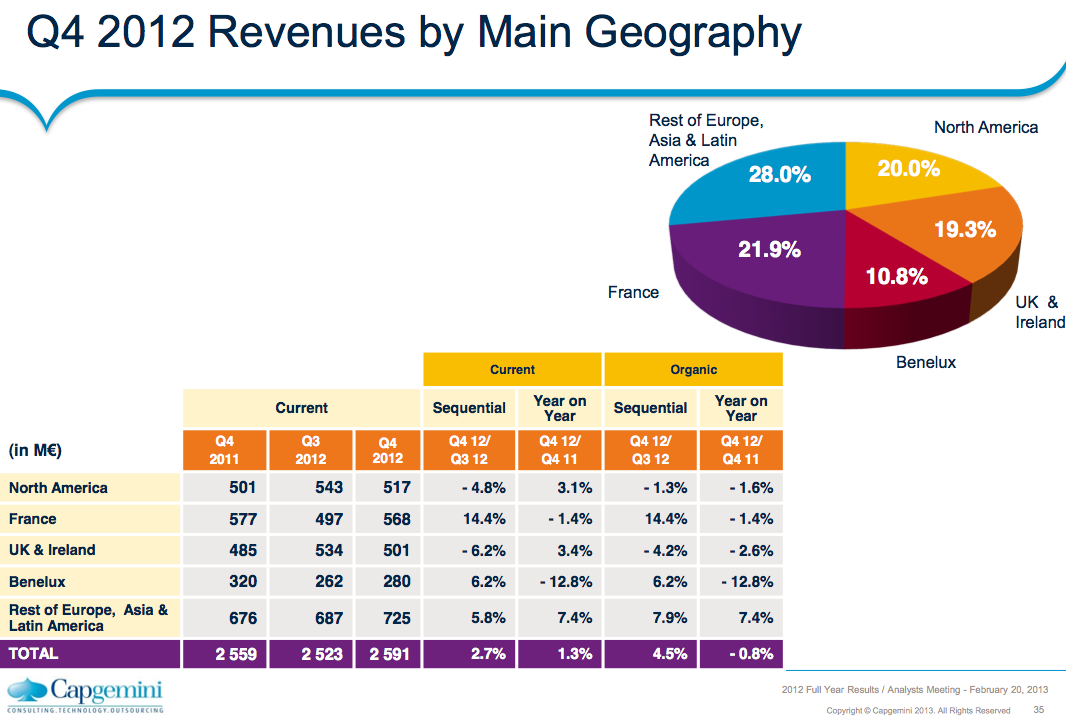

L'Amérique du Nord progresse de 16,4%

Le chiffre d'affaires de la région Amérique du Nord a progressé de 16,4% en 2012. Ce marché pèse désormais 20% du CA total de la SSII, contre 18% en 2010. Capgemini continue à être le premier acteur européen, avec 72% de son CA réalisé sur cette région. Quant aux marchés en développement, ils représentent maintenant 8% du total contre 2% il y a deux ans.

Cliquer ici pour agrandir l'image

Concernant la répartition par activités, l'intégration de systèmes reste le premier métier du groupe. Son chiffre d'affaires, en progression de 3,5%, pèse plus de 40% du total. Cette activité a enregistré « une croissance à 2 chiffres en Amérique du Nord et dans les pays nordiques », a précisé Aiman Ezzat, le nouveau directeur financier de Capgemini en poursuivant sur l'infogérance qui représente 40% du CA, « en augmentation de 0,5%, avec une décroissance au Royaume-Uni plus que compensé par la croissance en Allemagne et dans les pays nordiques ». Le taux de marge de l'activité, 7,6%, est « quasiment stable par rapport à 2011 ».

Baisse des revenus sur Sogeti et le conseil

En revanche, le chiffre d'affaires de Sogeti (15% du total) a enregistré un recul de 1,3% (à périmètre constant), « lié à l'activité en France et au Benelux, avec un taux de marge opérationnel en léger repli à 10,4% contre 10,9% en 2011 », a indiqué Aiman Ezzat lors de la conférence téléphonique des résultats. Enfin, c'est le chiffre d'affaires du conseil (les 5% restants) qui a été le plus impacté en 2012 avec une baisse de 3,6%. Cela reste néanmoins l'activité la plus rentable du groupe avec un taux de marge de 11,2%.

En France, le chiffre d'affaires a progressé de 2% à périmètre courant mais il est en retrait à périmètre constant, à cause des résultats du conseil et de Sogeti. Le taux de marge opérationnelle recule aussi. Enfin, le directeur financier signale aussi la variation du taux de crédit impôt recherche, modifié en 2012 (il sera reversé plus tard). Sur le Benelux, les revenus, en baisse de 11,7% sur l'année, se sont néanmoins stabilisés entre le 3e et le 4e trimestre.

Un frein sérieux sur les charges de restructuration

Pour 2013, Paul Hermelin estime qu'en dépit de la baisse du chiffre d'affaires sur le contrat Aspire, avec HMRC, la croissance organique devrait être comparable à celle de 2012. Le free cash flow devrait se situer entre 750 et 800 M€, a indiqué le PDG en précisant que la SSII avait mis un frein sérieux sur les charges de restructuration (moins de 80 M€). « Ce sont de bonnes nouvelles financières », mais sur un marché européen moins tonique comparé à celui des Etats-Unis.

Interrogé sur les rachats possibles en 2013, Paul Hermelin a expliqué que Capgemini ne cherchait pas « à consolider des activités de même nature », mais cherchait des acquisitions qui pourraient accélérer « la transformation du groupe vers de nouveaux business models » et des géographiques comme les Etats-Unis ou les marchés émergents. Historiquement, le groupe vend beaucoup de projets évalués sur un modèle nombre de collaborateurs/jour. La SSII cherche à passer à des modèles économiques sur lesquels les solutions sont vendues à la transaction, comme celui de Prosodie, a expliqué le PDG.

L'importance de l'activité offshore

Sur son activité offshore, Paul Hermelin a par ailleurs affirmé que Capgemini préservait massivement son emploi en France (21 738 personnes) et indiqué recruter 3 600 jeunes diplômés cette année. « Nous spécialisons les collaborateurs français sur des travaux qui demandent une présence locale. Et si nos clients choisissent des fournisseurs indiens, je préfère que ce soit Capgemini plutôt que Tata », a-t-il ajouté en expliquant : « Aujourd'hui, nous perdons contre des fournisseurs indiens à Paris ». Le dirigeant a expliqué qu'en accroissant la présence du groupe en Inde, cela augmentait la compétitivité du groupe et permettait de garder la relation client.

L'effectif offshore de Capgemini atteignait 50 425 personnes à fin 2012 dont 41 019 en Inde. Sur un effectif total de 125 110 personnes (119 707 fin 2011). Le groupe dit avoir recruter plus de 31 000 personnes l'an dernier, dont 54% en offshore. (...)

La BNF et le Centre Pompidou misent sur le web sémantique

Romain Wenz, expert métadonnées de la Bibliothèque Nationale de France (BNF) et Emmanuelle Bermès, chef du service multimédia du Centre Pompidou, travaillent autour d'un enjeu commun : ouvrir un catalogue provenant de divers silos de données à l'internaute. La BNF travaille, sur le site data.bnf.fr, à mettre en place un projet d'Open Data qui fasse le lien entre les archives du site, les livres numérisés via Gallica, ainsi qu'avec la totalité des notices bibliographiques en sa possession.

Pour l'utilisateur, cela passe par une page web qui livre toutes les informations relatives à un auteur ou à une oeuvre. Il s'agit de concaténer et de lier la totalité des données provenant de sites divers ou de différents catalogues pour les rendre plus visibles à la lecture. Pour cela, l'institution passe par une navigation via des pages HTML, réutilisables pour tous via une licence ouverte, mais aussi ouvertes techniquement via le RDF (Ressource Description Framework, ou modèle de description de données).

Trouver la bonne information par hasard

Les pages sont construites automatiquement à partir des informations des différents silos de données, et le but de ce site est, à terme, de devenir une référence utilisée par le plus grand nombre, d'où son ouverture à la réutilisation, même à des fins professionnelles.

Le futur site du Centre Pompidou, prévu pour le second semestre 2012, partage les même besoins et, pour Emmanuelle Bermès, le but des équipes qui travaillent sur le site est de provoquer « la sérendipité de l'internaute et tout est mis en place pour que celui-ci prolonge son expérience sur le site ». La sérendipité étant le fait de réaliser une découverte inattendue grâce à l'intelligence et au hasard. Il s'agit là encore de se servir du web sémantique pour faciliter la mise en ligne d'un modèle commun à tout le catalogue pour l'utilisateur malgré des silos de données divers et variés.

Ce mode d'analyse a donc un usage fort dans les unités ou administrations à consonance culturelle, afin de rassembler les données pour faciliter la visualisation et la navigation vers celles-ci. A l'heure où les recherches s'effectuent via les moteurs de recherche, il présente donc un intérêt certain.

(...)

Impact2012 : IBM traque les crimes avec une solution Big Data

Le pack d'IBM dénommé i2 Intelligence Analysis, est basé sur le logiciel de sécurité acquis l'an dernier suite au rachat de l'entreprise i2. Les institutions judiciaires et les services chargés de la sécurité dans les entreprises utilisent le logiciel i2 pour détecter des activités frauduleuses ou abusives en examinant les logs de données opérationnelles. Analyst's Notebook, le logiciel de recherche criminelle de l'éditeur, est capable d'afficher un diagramme visuel mettant en évidence les liens possibles entre des personnes, des lieux ou d'autres facteurs. Une vingtaine de langues sont prises en compte, dont le français.

Selon un article publié au moment du rachat de l'entreprise, i2 comptait plus de 4 500 clients dans 150 pays et affirmait que 12 des 20 plus grandes banques commerciales utilisaient son logiciel. La police de Boston et le système juridique pénal de Orange County, en Californie, partagent leurs données criminelles via la plateforme Coplink d'i2. L'armée américaine a acheté pour 9,6 millions de dollars une licence pour utiliser Analyst's Notebook avec son système de partage des données Distributed System Common Ground - Army (DCGS-A) au sein de l'armée. L'entreprise de défense Northrop Grumman a intégré Coplink d'i2 dans un système qu'il fournit à la Marine américaine pour pister des informations criminelles provenant de sources multiples.

Une solution intégrée aux technologies d'IBM

À l'automne dernier, IBM avait indiqué qu'il associerait la technologie i2 avec son propre logiciel de collecte, d'analyse et d'entreposage de données. Et l'annonce faite hier est un exemple de ce que Big Blue envisage de faire. Selon la firme, le pack lancé hier va apporter des fonctions puissantes de visualisation et d'analyse, couplées avec des systèmes avancés d'accès aux données. Les clients vont pouvoir gérer et traiter leurs informations en moins de temps et consacrer plus de temps à l'analyse.

Par ailleurs, i2 effectue:

- L'analyse par association, l'analyse de réseau, l'analyse des liens, l'analyse temporelle et géospatiale, et l'analyse statistique. À partir de là, i2 élabore une photographie complète, révélant les relations, les modèles et les tendances dans les données. Ce qui devrait faire gagner du temps et accroître l'efficacité.

- L'analyse des réseaux sociaux et les techniques d'analyse quantitative, lesquelles combinent théories de l'organisation et modèles mathématiques pour mieux comprendre et cibler la dynamique des groupes, des réseaux et des organisations.

I2 comporte encore :

- Des fonctions de travail collaboratif qui permettent à des groupes de travailler ensemble sur des affaires. Cela inclut le partage, le travail d'équipe, et la communication inter-et intra-organisationnelle. Cela devrait contribuer à résoudre les enquêtes plus rapidement.

- Une connectivité avancée et multi-source, des capacités de recherche simultanée pour automatiser et accélérer le lourd processus de collecte, de classement et d'enrichissement des données.

- La recherche dans les données non structurées à l'aide de fonctionnalités de recherche puissantes pour ratisser large et en profondeur et s'assurer qu'aucune donnée ne manque pour le travail d'investigation et l'activité opérationnelle.

- L'exploration en temps réel des renseignements, de façon à constituer un environnement extensible, évolutif et collaboratif en soutient de l'analyse opérationnelle, qui permet une prise de décision plus rapide et plus motivée.

[[page]]

Le pack i2 Intelligence Analysis comprend enfin :

- i2 Analyst's Notebook va permettre aux agences gouvernementales et aux entreprises privées d'optimiser au mieux la valeur des nombreuses informations qu'elles collectent. L'objectif est de découvrir et de partager des renseignements permettant d'identifier, de prévoir et prévenir des activités criminelles, terroristes, et frauduleuses.

- i2 Analyst's Notebook Connector pour ESRI: celui-ci intègre les fonctionnalités d'i2 Analyst's Notebook avec les capacités du serveur ESRI ArcGIS pour aider à la prise de décisions opérationnelles en temps voulu et en toute connaissance de cause. i2 Analyst's Notebook Connector pour ESRI permet d'accéder à des services de cartographie disponibles sur des environnements Esri Server. Celui-ci est compatible avec plusieurs outils de cartographie et d'analyse géospatiale qui servent à effectuer des analyses géospatiales essentielles sans avoir besoin de recourir à des analystes spécialisés dans les systèmes d'informations géographiques (SIG). Cela permet également à ces équipes de mener des analyses géospatiales plus approfondies. L'accès en self-service à ces données riches disponibles sur des serveurs ESRI (ils donnent accès à des cartes de base, à des fonctions de couches dynamiques, et des services SIG) directement à partir d'i2 Analyst's Notebook permet aux analystes d'avancer plus vite dans leurs recherches en profitant plus rapidement de certains renseignements. « Cela contribue à accroître la productivité du processus d'élaboration du renseignement, » a déclaré IBM.

- i2 Information Exchange i2 for Analysis Search for Analyst's Notebook permet à i2 Analyst's Notebook de se connecter à différentes sources de données distribuées, d'effectuer une recherche unique à travers ces multiples ressources, et de rapporter des informations dans i2 Analyst's Notebook pour la visualisation et l'analyse.

- i2 Information Exchange for Analysis Search Services SDK permet un accès sécurisé à de multiples sources de données, quel que soit leur type ou leur localisation, à travers des environnements informatiques hétérogènes. Il fournit un ensemble d'outils de développement et de la documentation, pour créer, étendre et personnaliser les composants de services Web et i2 Information Exchange i2 for Analysis Search for Analyst's Notebook.

- i2 Analyst's Notebook Premium s'appuie sur les capacités d'i2 Analyst's Notebook avec un référentiel d'analyse locale et des fonctionnalités de gestion des données améliorées, le repérage de l'information, plus des fonctions de cartographie, adaptées aux volumes croissants de données structurées et non structurées. « L'ajout d'un référentiel d'analyse locale pour i2 Analyst's Notebook et les nouvelles fonctionnalités de gestion des données améliorées, le repérage de l'information, la cartographie et la gestion graphique complètent l'offre pour les analystes qui ont besoin d'avoir accès à de plus grands volumes de données, en plus des données graphiques fournies avec i2 Analyst's Notebook », a encore déclaré IBM. Selon Big Blue, cette version de Notebook va permettre aux utilisateurs d'importer de plus gros volumes de données depuis des fichiers de données structurées à l'aide de l'assistant Visual Importer, qui permet aux utilisateurs de visualiser et d'analyser rapidement des types de données très divers, y compris les dossiers d'appels téléphoniques, les transactions financières, les logs des adresses IP des ordinateurs et des données judiciaires extraites des téléphones mobiles.

- i2 Intelligence Analysis Platform offre un environnement évolutif et collaboratif qui permet un partage du renseignement opérationnel et une prise de décision plus rapide et plus éclairée.

- i2 Fraud Intelligence Analysis permet d'apporter de nouveaux éclairages sur la base de données plus disparates, plus vastes et plus complexes, de façon à faciliter l'enquête, à bloquer et à prévenir la fraude. Fraud Intelligence Analysis permet de transformer des quantités massives de données et apparemment sans liens, en données intelligentes utiles pour la prise de décision. L'outil permet aussi de présenter les résultats d'une manière facile à comprendre », a déclaré IBM. i2 Fraud Intelligence Analysis peut être utilisé comme application d'identification de la fraude et de solution d'analyse autonome, des situations pour lesquelles il n'existe actuellement aucune solution autre que « manuelle ». i2 Fraud Intelligence Analysis peut également être déployé en conjonction avec d'autres produits de la maison pour l'analyse prédictive, la gestion des identités, les règles relatives aux processus opérationnels et la gestion des cas.

- i2 iBase est une base de données serveur SQL complète qui permet le travail collaboratif entre équipes d'analystes pour la collecte, le contrôle, et l'analyse des données provenant de sources multiples dans un environnement sécurisé. Il permet aussi la diffusion des résultats sous forme de renseignements susceptibles de donner lieu à une action en support à des opérations de renseignement.

(...)(23/04/2012 10:16:01)Harmonie Mutuelle choisit Digimind pour analyser ses données non-structurées

L'Union Harmonie Mutuelles protège 4,5 millions de personnes au travers des mutuelles adhérentes (Prévadiès, Harmonie Mutualité, la MNAM, Mutuelle Existence, Mutuelle Mare Gaillard, Mutuelle Santévie, Mutuelle SPHERIA Val de France et la SMAR). En 2012 va se créer Harmonie Mutuelle par fusion de ces assureurs.

Pour préparer cette fusion, l'Union a souhaité collecter et analyser de nombreuses sources d'informations pouvant la concerner. Il s'agit pour elle de mettre en oeuvre une veille stratégique. Pour y parvenir, l'Union a choisi un outil d'intelligence économique, Digimind. L'automatisation de la collecte et de l'analyse de gros volumes données non-structurées ont été des critères majeur de choix ainsi que l'accès simple aux résultats. Le coût du projet n'a pas été dévoilé. (...)

IBM complète ses solutions analytiques avec Varicent Software

Le portefeuille de solutions d'analyse de données d'IBM s'enrichit d'un axe complémentaire. Avec le rachat de l'éditeur canadien Varicent Software, il s'agit cette fois de logiciels de gérer la performance des équipes commerciales : gestion des territoires, des quotas et de la rémunération des vendeurs. L'acquisition a été annoncée vendredi dernier, mais les termes de la transaction n'ont pas été dévoilés.

Basée à Toronto, Varicent est une société privée fondée en 2003. Elle compte 180 entreprises clientes, parmi lesquelles des banques, des compagnies d'assurance, des chaînes de boutiques, des fournisseurs de solutions IT et de services de télécommunications. On trouve parmi les sociétés ayant utilisé ses produits des groupes comme Hertz et Office Depot. L'éditeur propose deux versions de son offre, l'une destinée aux entreprises ayant entre 50 à 250 commerciaux, l'autre s'adressant aux groupes comptant plus de 250 commerciaux. Ses produits sont disponibles en mode cloud ou en version traditionnelle à installer sur site.

Des packages logiciels assignés à des applications ciblées

Varicent Software rassemble et compile des informations gérées sur différents systèmes informatiques (finance, gestion commerciale, ressources humaines...) pour analyser les ventes et disposer d'éléments pour organiser les activités. Son logiciel sera versé au portefeuille Smarter Analytics d'IBM où il s'ajoutera aux solutions d'Algorithmics, de Clarity Systems, d'OpenPages, de Cognos et de SPSS. Pour se constituer une expertise dans le domaine de l'analyse de données, IBM rappelle qu'il a racheté 28 sociétés depuis 2005, ce qui lui a permis de se constituer un écosystème de 27 000 partenaires.

Les solutions sont combinées pour proposer des packages couvrant des applications spécifiques comme les Smarter Analytics Signature Solutions destinées à la détection des fraudes, par exemple, ou encore à l'optimisation de la gestion financière ou de la relation client. IBM a aussi récemment annoncé les Smart Analytics Systems associant une plateforme matérielle avec des logiciels analytiques, de la BI (business intelligence) et des systèmes de traitement d'importants volumes de transactions.

Big Blue prévoit de générer 16 milliards de dollars d'ici 2015 dans la commercialisation de systèmes d'analyse de données et de services associés. Il dit réunir à ce jour près de 9 000 consultants et équipes opérationnelles se consacrant à ces systèmes. S'y ajoutent 400 chercheurs travaillant dans ce domaine, qui garantissent au groupe américain plusieurs centaines de brevets par an.

SAP déploie son offre pour peser plus lourd dans les bases de données

Qui ignore encore que SAP a placé HANA, son appliance d'analyse en mémoire, au coeur de sa stratégie, avec d'énormes ambitions affichées sur le marché des bases de données ? En décembre dernier, Steve Lucas, vice-président exécutif de SAP, responsable de l'entité Analytics, Database & Technology, s'était même risqué à prédire que l'éditeur serait n°2 sur ce terrain d'ici 2015. Cette semaine, le fournisseur allemand a enfoncé le clou en présentant sa feuille de route pour HANA, plateforme sur laquelle l'ensemble de son offre applicative va progressivement prendre appui.

La majorité des clients de SAP exploitent aujourd'hui l'offre de gestion intégrée Business Suite avec l'une des grandes bases de données concurrentes, principalement Oracle, mais aussi DB2, d'IBM. L'éditeur allemand espère bien les convaincre de passer un jour à HANA, mais le nécessaire travail d'ingénierie pour y parvenir n'est pas encore achevé.

Pour atteindre son but, SAP mise aussi sur les produits qu'il a rachetés avec Sybase en 2010. Et d'abord la base de données Sybase ASE (Adaptive Server Enterprise). Le portage de la Business Suite sur Sybase ASE devrait être disponible ce mois-ci, a annoncé mardi dernier Vishal Sikka, directeur technique et membre du comité exécutif de SAP, lors d'une conférence de presse à San Francisco.

Un fond de capital-risque de 155 M$ pour les start-up d'HANA

Pour l'instant, HANA est avant tout adaptée aux applications analytiques. Dans ce domaine, SAP a annoncé en novembre que sa plateforme de datawarehouse, BW, pouvait maintenant tirer parti de l'appliance d'analyse en mémoire. « BW sur HANA constitue une amélioration très significative tant en termes de coûts que de performances », a redit Vishal Sikka en rappelant que cette mise en place se faisait sans remettre en cause l'existant chez les utilisateurs de BW. Il affirme que la période de « ramp-up » de BW sur HANA, pendant laquelle le produit a été mis en place auprès d'un nombre restreint de clients (les « early adopters »), a été la plus courte constatée jusqu'à présent dans l'histoire de SAP. A ce jour, près de 80 exemplaires de cette offre ont été livrées à des clients ou des partenaires, a indiqué le directeur technique.

Ce mardi, SAP a également annoncé qu'il allait créer un fond de capital-risque de 155 millions de dollars qui sera consacré aux start-up qui construiront des applications sur la plateforme HANA. L'éditeur a également prévu d'investir 337 millions de dollars dans un programme destiné à attirer les clients vers HANA. Dans ce cadre, SAP proposera des services de conseil pour les nouveaux clients qui veulent effectuer des migrations vers HANA depuis les bases de données qu'ils utilisaient jusque-là.

Un programme d'échange pour les clients insatisfaits

SAP va par ailleurs mettre à la disposition des clients HANA ayant terminé d'installer le logiciel un programme d'échange qui leur permettra de revenir à leurs précédentes licences SAP, pendant un délai de dix-huit mois, s'ils ne sont pas satisfaits.

Enfin, l'éditeur veut s'assurer que les développeurs et les administrateurs de bases de données disposent bien des bonnes ressources de formation autour d'HANA. Et qu'ils peuvent accéder gratuitement aux environnements de tests, a indiqué de son côté Steve Lucas, le responsable de l'activité Analytics, Database & Technology, en s'accordant une digression bucolique : « Nous devons construire un environnement propre à faire éclore des milliers de fleurs ».

Sybase monte en puissance

Au cours de la conférence, SAP a livré d'autres détails sur le rôle qu'il comptait faire jouer aux autres produits du portefeuille Sybase, d'ici à 2015. Certaines de ses intentions étaient déjà connues. Ainsi Sybase IQ, sa base de données en colonnes, sera étroitement associée à HANA pour le stockage des données « froides » ou plus anciennes. Il est prévu que le produit partage des capacités et un cycle de vie communs avec HANA, a précisé SAP.

SQL Anywhere, la base de données mobile embarquée de Sybase, sera utilisée à des fins de stockage en « front-end » pour la plateforme HANA. La solution de modélisation PowerDesigner devrait également jouer un rôle clé, a ajouté SAP. L'éditeur prévoit par ailleurs de réaliser une intégration entre HANA et les sources de données incluant le framework Open Source Hadoop.

SAP a expliqué que plusieurs modules importants de la Business Suite allaient être portés vers HANA d'ici à la fin de cette année. Un projet qui avance « extrêmement bien », a indiqué Vishal Sikka durant la conférence de presse.

Mark Hurd, coprésident d'Oracle, expose sa vision de l'analyse décisionnelle

Avec sa salve d'annonces faites en milieu de semaine, Oracle veut se positionner comme un acteur principal du secteur de l'analyse décisionnelle et se montrer plus pertinent aux yeux des clients de son rival SAP. Le mois dernier, l'éditeur avait déjà évoqué les grandes lignes de sa stratégie, dont le détail a été publié sur son site Intenet mercredi. Le même jour, le coprésident d'Oracle, Mark Hurd, a donné encore plus de précisions à ce sujet au cours d'un webcast qu'il a tenu pendant la conférence OpenWorld de Tokyo.

L'articulation choisie par Mark Hurd tourne autour des dangers que vont représenter les quantités toujours plus grandes d'informations numériques. « La quantité de données sur la planète est tout simplement énorme, » a-t-il déclaré. « Et, j'ai de mauvaises nouvelles. Cela va s'aggraver. La vraie question est de savoir comment obtenir la bonne information auprès de la bonne personne au bon moment pour prendre la bonne décision, » a-t-il ajouté. « Et ce n'est pas facile. »

Prendre la bonne décision des centaines de fois

Le dirigeant d'Oracle a cité le cas d'un agent posté à la porte d'embarquement d'un aéroport. Celui-ci doit décider à quel passager donner le dernier siège sur un vol dont les sièges ont été survendus. « Sa décision va changer la relation existant entre le passager et la compagnie aérienne pour la vie », a-t-il déclaré. « S'il donne la place à quelqu'un d'autre que vous et qu'il vous force à attendre trois ou quatre heures pour attraper le prochain vol, vous n'allez probablement jamais l'oublier. Et si l'agent de la compagnie aérienne doit prendre ce genre de décision des centaines de fois, il est important qu'il fasse le bon choix. C'est la raison pour laquelle cette nouvelle génération de systèmes analytiques décisionnels est si importante. »

Dans la série d'annonces produits faite mercredi, Oracle a mis en avant sa gamme de logiciels d'analyse et sa machine Exalytics, laquelle, comme la plate-forme HANA de SAP, utilise le traitement in-memory adapté aux charges de travail analytique haute performance. Une autre annonce concerne la version 11.1.2.2 de l'EPM (Enterprise Performance Management) Hyperion. « Contrairement à ce que laisse imaginer son nom, la mise à jour est loin d'une version release, avec ses nombreuses fonctionnalités et ses améliorations, » a déclaré Paul Rodwick, vice-président de la gestion produits pour Oracle BI, dans une interview donnée avant l'intervention de Marck Hurd. Parmi ces nouvelles fonctionnalités, on trouve des modules d'application pour la planification financière et le rapprochement des comptes, l'intégration avec Exalytics, une expérience utilisateur revisitée et de nouvelles passerelles entre Hyperion Data Relationship, Oracle 12.1 E-Business Suite et Fusion Financials, lesquelles permettent « une intégration plus rapide et plus facile des plans comptables et d'autres données financières entre applications ERP, » comme l'a déclaré Oracle.

[[page]]

Mercredi également, Oracle a annoncé Endeca Information Discovery, un produit qui résulte du rachat d'Endeca l'an dernier. Le système permet aux utilisateurs de parcourir finement des données structurées et non structurées selon un mode itératif dit « model-as-you-go », comme le précise un communiqué. Cette fonctionnalité est combinée à « une expérience utilisateur acquise dans le domaine du e-commerce, » a encore déclaré Oracle. « La plate-forme est notamment utilisée dans l'analyse des demandes d'indemnisations dans le secteur de l'assurance et dans l'analyse des tendances sur les réseaux sociaux », a ajouté Oracle. Selon un porte-parole, Endeca information Discovery sera certifié pour Exalytics en milieu d'année.

Oracle a également annoncé une série d'applications spécialisées que les clients de SAP peuvent utiliser pour analyser les dépenses et les achats, et dans la chaîne d'approvisionnement et de gestion des commandes. Le vendeur a aussi annoncé deux nouvelles applications analytiques pour les systèmes Oracle. L'une, qui permet aux fabricants d'avoir un aperçu sur leurs opérations, et une autre qui permet aux entreprises de visualiser comment sont utilisées leurs ressources, véhicules et équipements par exemple.

« SAP, qui ne prend pas Oracle à la légère, remporte sur le terrain beaucoup de succès face à son rival. En particulier, nous réussissons à supplanter Hyperion avec notre propre logiciel EPM Business Objects, » a déclaré Sanjay Poonen, président et corporate officer Global Solutions, chez SAP, dans une interview donnée avant les annonces d'Oracle.

(...)(04/04/2012 13:36:33)Analyse prédictive : SAP veut concurrencer SAS et IBM

Avec son application Business Objects Predictive Analysis, SAP espère faire une intrusion sur le marché du logiciel d'analyse prédictive. L'application est actuellement en phase de « pré-lancement», un terme utilisé par SAP pour désigner une sortie très contrôlée. L'application comporte un ensemble d'algorithmes prédictifs et sait également traiter les algorithmes écrits avec le langage Open Source R pour l'analyse statistique.

L'analyse prédictive diffère de la BI (business intelligence) traditionnelle. Au lieu de faire tourner des rapports statiques sur les ventes ou les niveaux des stocks, le logiciel explore et modélise les données d'entreprise, il établit des corrélations et cherche des tendances qui permettent de mieux comprendre les événements, les comportements des clients et d'autres éléments à venir. « Le marché et nos clients attendent avec impatience que SAP leur propose un outil qui leur permettra d'adopter une stratégie prédictive concrète, » a déclaré Mani Gill, vice-président et General manager des solutions de business intelligence dans un blog posté mardi sur le site de l'éditeur. « Ce moment est arrivé, » a-t-il ajouté.

Des acteurs déjà bien installés sur le marché

Sur ce marché, SAP va se trouver en concurrence avec des produits d'analyse prédictive déjà bien installés, comme ceux de SAS Institute, du département SPSS d'IBM et du data mining d'Oracle, mais aussi avec des produits proposés par un certain nombre de start-ups, comme Revolution Analytics, qui supportent le langage Open Source R.

Business Objects Predictive Analysis sera proposé en version autonome, mais SAP prévoit également de le coupler avec sa base de données in-memory HANA, qui dispose d'une bibliothèque de fonctions statistiques, comme le précise un communiqué. D'après le billet posté par Mani Gill, le logiciel permettra également d'accéder à d'autres bases de données, notamment celles d'Oracle.

Selon SAP, les utilisateurs vont disposer « de magnifiques fonctions de visualisations et d'exploration de données avancées, le tout dans une interface drag-and-drop pour effectuer la sélection, l'organisation et le traitement des données ». Toujours selon l'éditeur, il sera également possible d'envoyer les résultats vers d'autres applications de BI de SAP, des terminaux mobiles et vers Microsoft Office. « L'analyse prédictive est une pratique encore réservée aux statisticiens, mais les salariés des entreprises veulent pouvoir disposer de données prédictives pertinentes », écrit encore Mani Gill dans son blog. « Nous voulons offrir à tous les utilisateurs ce dont ils ont besoin. »

(...)(08/03/2012 17:20:54)SAP présente son appliance in-memory HANA à ses clients français

SAP France passe aux choses sérieuses avec HANA. Cette appliance, qui associe la technologie logicielle de l'éditeur à une infrastructure matérielle apportée par des partenaires constructeurs (HP, IBM, Siemens, Fujitsu...), vient donner un énorme coup d'accélérateur à l'analyse d'importants volumes de données montées en mémoire vive. Une performance permise par la baisse de coût importante sur le prix des mémoires vives au cours des années et les avancées technologiques. Les temps de réponse des applications décisionnelles s'en trouvent très sensiblement réduits, quelquefois de façon spectaculaire. Les clients en production font état de performances multipliées par 1 000, 10 000, ou davantage. Mais, bien au-delà des applications de Business Intelligence, SAP a l'ambition de mettre HANA au service de l'ensemble de ses applications de gestion et, à terme, de l'imposer en lieu et place de la base de données. L'éditeur mise énormément sur cette solution promue par Hasso Plattner, l'un des co-fondateurs historiques de la société, qui l'a présenté pour la première fois en mai 2009.

Ce matin, à Paris, les équipes françaises de SAP ont déroulé les apports de la solution à plusieurs dizaines de clients. Avec HANA, « SAP revoit la pile logicielle classique telle que vous la connaissez et la simplifie en mettant tout en mémoire », a rappelé Jean-Michel Jurbert. « Ce n'est pas seulement une base de données en mémoire mais une plateforme applicative in- memory pour des données venant d'autres systèmes que SAP ».

Provimi n'était pas satisfait des performances de BW

Les utilisateurs de la solution de datawarehouse BW figurent parmi les premiers clients à pouvoir profiter des bénéfices de HANA. C'est le cas de Provimi, invité ce matin à expliquer de quelle façon l'installation de l'appliance a amélioré ses temps de réponse. Un projet mené tambour battant en trois semaines. Ce spécialiste mondial de la nutrition animale (racheté par Cargill) gère 67 usines dans le monde. Il a uniformisé sa gestion autour de SAP (modules MM, SD, FI, COPA, logistics et applications VIM, GRC, Quality Management et CRM). Avant HANA, la chaîne de reporting qu'il avait mise en place s'appuyait sur BW comme source d'information principale. D'un point de vue plus stratégique, la direction de Provimi utilise BPC [Business Planning & Consolidation], logiciel de planification et de consolidation financière.

Mais tout le monde accède aux mêmes valeurs de stocks quels que soient les outils que l'on utilise, qu'il s'agisse de BW, d'ECC [les modules de l'ERP] ou de BPC, il n'y a qu'une vérité », explique Jean-Charles Valette, directeur du contrôle de gestion de Provimi. Le projet lié à BW visait à répondre aux questions du management et à détecter de nouvelles tendances dans le business pour réagir rapidement et gagner des parts de marché. « Mais nous n'en avions pas tiré les bénéfices escomptés, relate Jean-Charles Valette. Il nous fallait parfois cinq minutes pour récupérer les résultats d'une requête (et il fallait généralement enchaîner une vingtaine de requêtes). En clôture mensuelle, nous perdions également beaucoup de temps. L'état des stocks et des commandes n'était pas disponible en temps réel. De plus, nous avions mis du temps pour installer BW et nous devions passer par la IT pour disposer de nouveaux indicateurs clés ou adapter nos requêtes à d'autres demandes ».

Des temps de réponse tombés à 5 ou 10 secondes

Provimi gère 100 millions de données dans SAP. La société savait qu'en les exploitant bien, elle pouvait récupérer des informations « colossales » pour prendre des décisions. « En octobre, nous sommes allés à Walldorf [siège de l'éditeur en Allemagne]. Trois jours plus tard, SAP nous a montré ce qu'ils pouvaient faire avec nos données », poursuit Jean-Charles Valette. Un environnement de test est développé avec une quinzaine de dimensions. « C'était déjà très rapide, nous obtenions des réponses en 5 à 10 secondes. Nous avons décidé de mettre HANA en place ». Ce qui s'est fait avec l'appui de Capgemini. « En trois semaines, nous avions un pilote live ».

Le 13 octobre 2011, l'appliance arrive dans le datacenter de Provimi, quinze jours plus tard, toutes les tables de production utiles étaient dans HANA. Les premiers utilisateurs de HANA (douze personnes) donnent un feedback immédiatement positif, appréciant notamment l'interface conviviale de Business Objects Explorer (BOE). Les résultats ne se font pas attendre. Provimi réussit à la fois à générer des revenus et à réduire ses coûts. Le directeur du contrôle de gestion explique comment des niveaux de stocks anormalement élevés ont pu être identifiés, ce qui a permis de les réduire de 2 millions d'euros.

« Nous attendons aussi de gros bénéfices sur notre clôture mensuelle, avec un objectif de trois jours ouvrés, ce que ne permet pas notre chaîne de reporting pour l'instant », ajoute Jean-Charles Valette. « Nous sommes encore en phase de pilote dans HANA, il y a encore à développer. » Jusqu'à peu, par exemple, il n'était pas possible de disposer de données consolidées dans une monnaie de référence. « Nous allons faire dans HANA des traitements que nous ne pouvions pas envisager dans BW ». Mais HANA n'a pas encore toutes les fonctions actuellement accessibles dans BW. En complément, Capgemini explique que HANA a été mis en place sur BPC, la réplication s'effectuant dans l'appliance en temps réel depuis ECC, le reporting étant réalisé sur cette base.

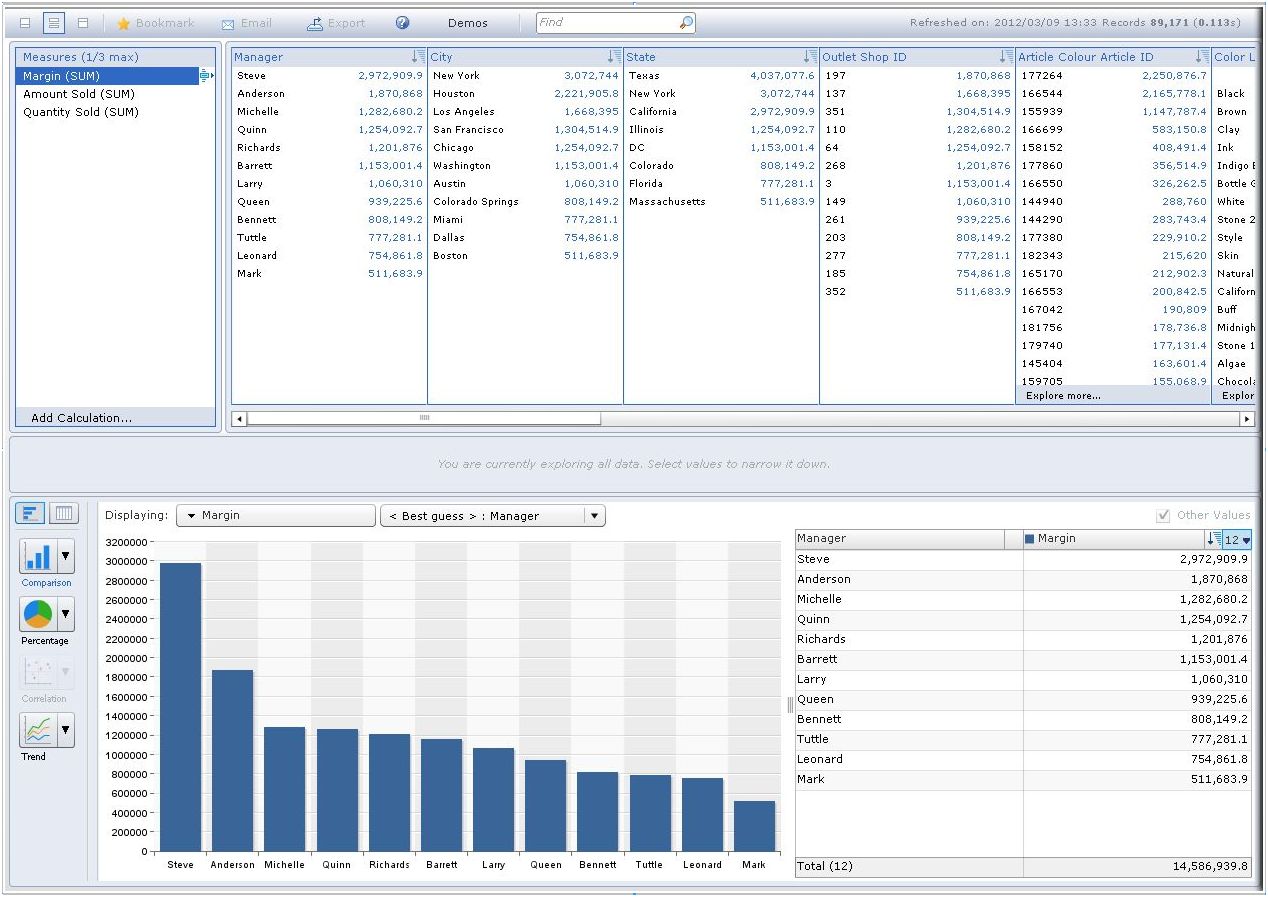

En frontal de l'appliance HANA, le logiciel d'exploration des données BO Explorer offre une interface facile à manipuler (source : https://www.experiencesaphana.com/community/try)

Microsoft et Hortonworks vont relier Excel à Hadoop

Microsoft travaille à la mise au point d'un connecteur qui permettra aux utilisateurs d'Excel de télécharger et d'analyser des données provenant de Hadoop. Cette fonctionnalité pourrait ouvrir à un public plus large la plate-forme de traitement de données disponible en Open Source. Le développement est réalisé en collaboration avec Hortonworks, une spin-off de Yahoo, qui propose une distribution de Hadoop avec un support commercial. « Cette annonce est importante, parce que Microsoft ouvre potentiellement Apache Hadoop à des millions de nouveaux utilisateurs », a déclaré Eric Baldeschwieler, co-fondateur et directeur technique d'Hortonworks. « Ce sont aussi plusieurs millions d'utilisateurs PowerPivot pour Excel qui vont bientôt pouvoir exploiter les capacités d'Apache Hadoop à partir d'un logiciel qu'ils connaissent bien. »

Le développement de ce connecteur est l'un des nombreux projets Open Source en relation avec Hadoop que Microsoft et Hortonworks ont annoncé mardi lors de la conférence O'Reilly Strata Data, qui se tient cette semaine (28 février-1er mars) à Santa Clara, Californie. L'an dernier, les deux entreprises avaient conclu un partenariat pour adapter Hadoop à l'écosystème Windows. Microsoft et Hortonworks travaillent également ensemble pour élaborer un framework JavaScript, qui permettra aux programmes JavaScript d'explorer les données de Hadoop. Il collaborent aussi sur une série de patchs pour le noyau Hadoop qui doit permettre au logiciel de tourner sur Windows Server.

Connecteur et bibliothèque bientôt en Open Source

Le connecteur est une interface ODBC (Online Database Connector) qui interagit avec Hadoop par l'intermédiaire du système d'entreposage de données Hive. Les utilisateurs pourront analyser les données téléchargées depuis Hive dans Excel, en utilisant des outils comme PowerPivot pour Excel. « Le pilote ODBC de Microsoft pour Hive a été construit pour connecter plus facilement Excel, PowerPivot et d'autres outils Microsoft à Hadoop (via Hive) », a déclaré par mail Shaun Connolly, vice-président, stratégie d'entreprise, d'Hortonworks. Il explique que sa société et Microsoft veulent mettre cette technologie en Open-Source afin qu'elle soit largement disponible et utilisée par la communauté Apache Hadoop. Le développement du framework JavaScript suivra le même chemin, a indiqué Shaun Connolly.

Microsoft a construit la plate-forme centrale pour ses propres produits et Hortonworks la modifiera pour permettre une utilisation élargie. « Pour l'instant, ni le connecteur, ni le framework Javascript ne sont disponibles, mais ils seront livrés prochainement en version open-source », a déclaré le vice-président de Hortonworks. Microsoft a déjà fait un pas pour intégrer Hadoop dans son écosystème puisque l'éditeur propose un connecteur Hadoop pour SQL Server. Il offre également la connectivité à une instance de Hadoop - actuellement en version développeur - sur son service cloud Azure.

| Les 10 documents suivants > |