Plonger dans les données opérationnelles non structurées et les explorer à la recherche de quelque chose que l’on ne connaît pas, c’est ce que permet Splunk dont le nom fait écho à spelunking, spéléologie en anglais. Cette plateforme permet de rechercher, surveiller, analyser et corréler les « données machines » générées par le système d’information pour trouver la source d’incidents opérationnels, donner des réponses aux métiers (sur les performances d'un site de vente en ligne par exemple) ou faire face à des menaces de sécurité (en incluant la gestion des fraudes). Hier, sur Splunk Live Paris 2016, la conférence annuelle de l'éditeur, les démonstrations et témoignages ont suscité un vif intérêt chez les utilisateurs français du produit, même si, comme l’un d’eux l’a souligné, il ne s'agit pas non plus « d’un outil magique ». La solution existe en version on premise et cloud ainsi que dans une déclinaison Light pour les petits environnements informatiques.

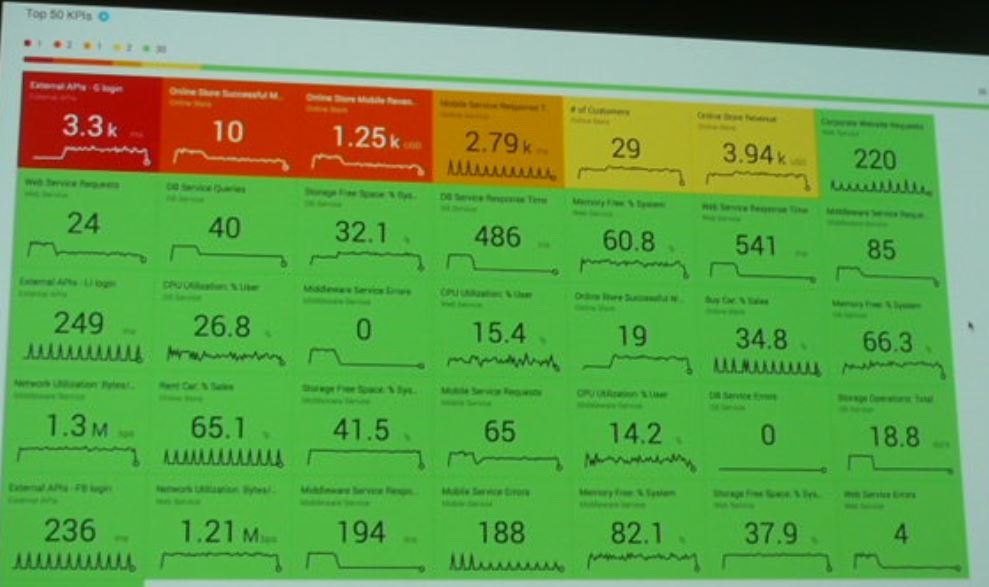

L'analyse des logs collectés permet d'obtenir de multiples indicateurs clés de performance dans de nombreux domaines. (agrandir)

Pour l’entreprise qui veut explorer les capacités de la solution sur la collecte et l’analyse des logs de son SI, il est possible de commencer sur un périmètre déterminé. Parmi les témoignages de la matinée, l’équipe IT de Neocles, filiale d’OBS spécialisée sur la centralisation et la virtualisation de postes de travail (c'est l'un des premiers intégrateurs de Citrix il y a 20 ans), n’avait fixé au départ ni le budget ni le temps pour mettre en place l’outil, mais le pilote qu'elle réalise concrétise rapidement l'intérêt de le déployer. La société accompagne ses clients dans des projets cloud sur-mesure de postes de travail virtuels qui réunissent une grande variété de technologies. Elle gère 2 000 serveurs sur 3 datacenters. Avant d’utiliser Splunk, dans le cadre de l’offre phare d’OBS « Forfait informatique » (gestion des applications métiers des clients, de la messagerie et de la bureautique), l’équipe IT exploitait les logs à partir d’outils développés en interne et de tableaux de bord sur Excel.

Un pilote mis en place sur 10 Go de données

Pour permettre à Neocles de démarrer rapidement le pilote, Splunk « prête » pendant deux mois une licence pour indexer 10 Go de données. « Nous avons admis de ne pas mettre tous nos logs sur Splunk et nous sommes focalisés sur ceux qui avaient le plus de valeur », a relaté Cyril Godon, responsable de l’ingénierie de production de la société. Parmi les plus importants se trouvent en particulier ceux qui permettent de mesurer la qualité perçue par les utilisateurs de VDI. Le pilote de Neocles s’est concentré sur 5 points clés : les fonctionnalités de paramétrage, l’installation globale de l’architecture de collecte, la validation de l’agent Universal forwarder qui renvoie les données, un suivi fin de la consommation de la licence et la configuration des règles de filtrage.

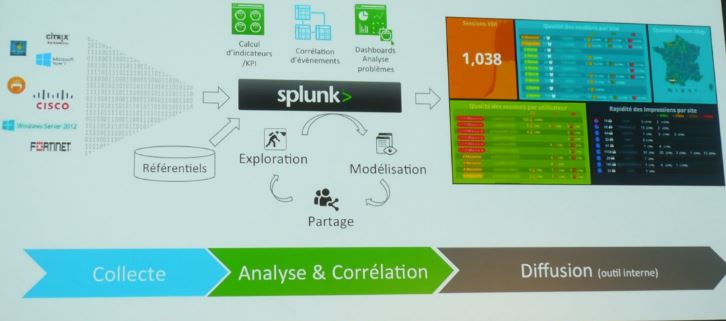

L'intégration de Splunk dans l'écosystème de Neocles. (agrandir / crédit : D.R.)

Très rapidement, la mise en place de Splunk par Neocles génère de nombreuses demandes en interne ce qui contribue à faciliter son financement. A partir de 2013, la valorisation fonctionnelle des données se fait à travers des tableaux de bord qui présentent des indicateurs de qualité de service et font apparaître tout le potentiel que peut apporter l’exploitation des logs. En 2015, la vue 360 permet d’afficher facilement toutes les données en fonction des recherches effectuées sur les utilisateurs et les serveurs, par exemple sur l’évolution de la qualité d’ouverture de session, sur les temps d’attente d’ouverture de session, etc. « Nous sommes capables de gérer tous les points particuliers dans les configurations et tous les cas spécifiques chez les clients. Splunk est l’outil qu’il nous fallait pour entrer dans un nouvelle ère de pilotage de nos services », estime Cyril Godon.

Parmi les éléments clés ayant participé à la réussite du projet Splunk et à faire passer le volume de données traité de 10 à 50 Go en trois mois, Neocles cite la capacité à avoir pu qualifier très rapidement plusieurs problèmes. La publication de l’indicateur métier « Qualité perçue par l’utilisateur » y a également contribué, ainsi que le déploiement en 48 heures d’un nouveau périmètre complexe pour aider le client à qualifier un problème applicatif majeur. En conclusion, pour déployer la plateforme de collecte de logs, l’équipe de la filiale d'OBS conseille de commencer par une petite licence de test, de se concentrer sur les logs qui ont le plus de valeur, de conserver une marge de licence pour faire face à toute opportunité, de choisir des indicateurs métiers qui parlent à tout le monde, mais avant tout, de valoriser les données en soignant la présentation des tableaux de bord. « Il faut rendre ses données accessibles et les partager avec le plus grand nombre », souligne Julien Lemoing, architecte du département Solutions.

Generali vise la détection automatique d'incidents

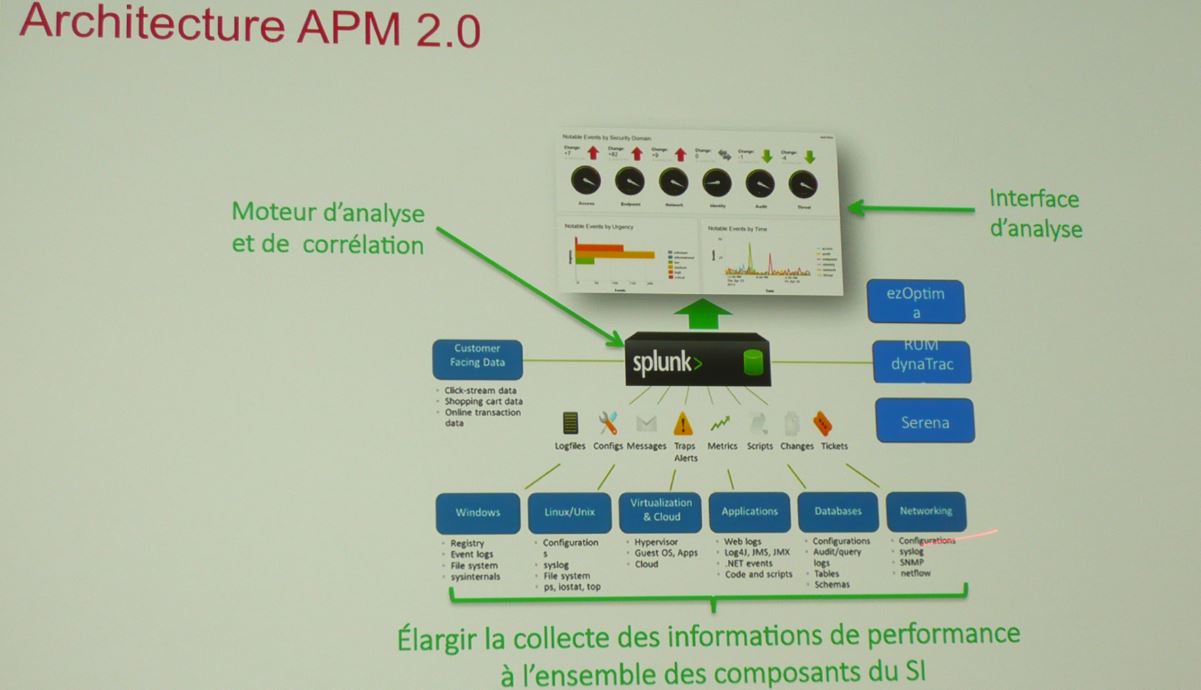

Parmi les autres interventions de Splunk Live Paris 2016, Generali recourt à la plateforme pour gérer la performance délivrée à ses utilisateurs. Dans le cadre de son projet APM 2.0, le groupe d’assurances s’attache à accélérer le processus permettant d’isoler les causes de lenteur. Avec Splunk, il élargit la collecte des informations de performance à l’ensemble des composants de son système d’information. L'idée était de disposer « d'une valise de diagnostic » pour fluidifier le déploiement applicatif, a notamment expliqué Cyril Thenon, responsable de la performance à la direction Production et Services qui assure l'intégration applicative et l'exploitation IT. Le groupe compte 11 000 utilisateurs, 4 000 agents Generali et 7 000 courtiers et partenaires.

L'industrialisation des processus de déploiement chez Generali porte sur 430 applications sur 4 500 serveurs avec un millier de JVM et 600 bases de données. (agrandir / Crédit : D.R.)

Avec Splunk, l'objectif est d'arriver idéalement à la détection automatique d'incidents, a indiqué Cyril Thenon en soulignant néanmoins que l'outil n’était pas magique, qu’il restait un outil avec lequel il faut créer de la valeur en lui associant les bonnes compétences. Il pointe la nécessité de bien concevoir l’architecture et les requêtes pour gagner en rapidité d’analyse et rappelle que les tableaux de bord sont inutiles sans l’analyse humaine. Il est prévu de faire appel à l'équipe européenne de data scientists du groupe pour combiner ses compétences avec celles des autres équipes IT. Un troisième témoignage a été apporté par la banque de financement Natixis (groupe BPCE) qui réunit 16 000 collaborateurs et a recouru à Splunk pour la mise en place d'un SIEM pour gérer la sécurité du SI.

65 000 questions/réponses sur answers.splunk

Créé en 2003, Splunk est aujourd’hui une société de plus de 2 000 collaborateurs qui a dépassé le cap des 11 000 clients, le plus important d’entre eux ayant acquis une licence pour suivre avec la plateforme un volume de 1,2 petaoctets de données par jour. Au fil des années, la communauté qui s’est créée autour de la plateforme a généré une base d’échanges de 65 000 questions/réponses sur le site answers.splunk. Un millier d’applications ont par ailleurs été créées au-dessus de Splunk. Développées par des tiers, ces applications add-on ne sont, pour l’essentiel, pas supportées par l’éditeur, rappelait hier matin un client.

Commentaire